Einheitliche Veröffentlichungen

2022

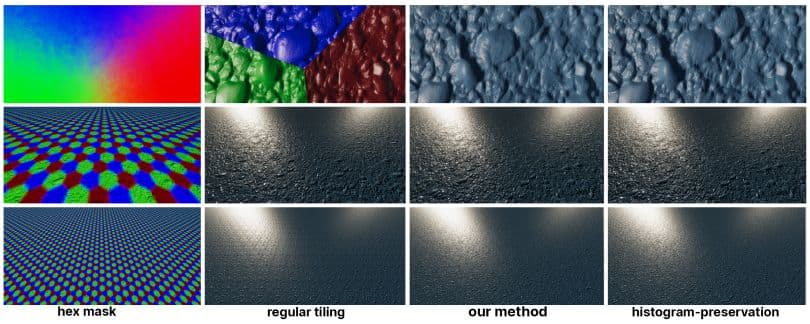

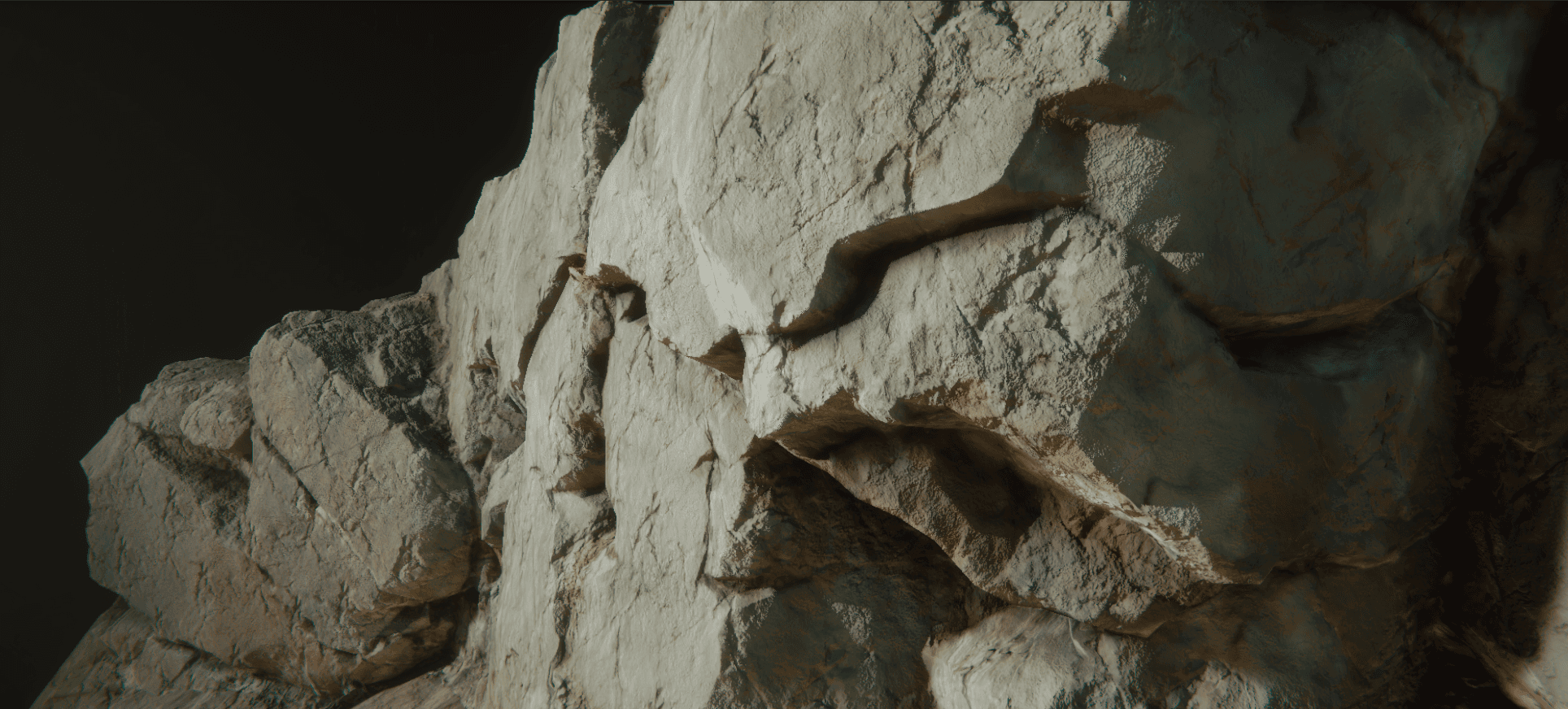

Praktisches Hex-Tiling in Echtzeit

Morten S. Mikkelsen - Zeitschrift für Computer-Grafik-Techniken (JCGT)

Um einen bequemen und einfach zu handhabenden Ansatz für zufällig gekachelte Texturen im Kontext der Echtzeitgrafik zu bieten, schlagen wir eine Anpassung des By-Example-Noise-Algorithmus von Heitz und Neyret vor. Die ursprüngliche Methode erhält den Kontrast mit Hilfe einer histogrammerhaltenden Methode, die einen Vorberechnungsschritt erfordert, um die Quelltextur in eine Transformations- und eine inverse Transformations-Textur umzuwandeln, die beide im Shader abgetastet werden müssen, anstatt die ursprüngliche Quelltextur. Daher ist eine tiefe Integration in die Anwendung erforderlich, damit dies für den Autor des Shaders und des Materials undurchsichtig erscheint. Bei unserer Anpassung verzichten wir auf die Histogrammerhaltung und ersetzen sie durch eine neuartige Überblendungsmethode, die es uns ermöglicht, die ursprüngliche Ausgangstextur zu erfassen. Diese Unterlassung ist besonders bei einer Normalen-Karte sinnvoll, da sie die partiellen Ableitungen einer Höhenkarte darstellt. Um den Übergang zwischen den Sechseckkacheln zu entschärfen, führen wir eine einfache Metrik zur Anpassung der Überblendungsgewichte ein. Bei einer Farbtextur verringern wir den Kontrastverlust, indem wir eine Kontrastfunktion direkt auf die Überblendungsgewichte anwenden. Obwohl unsere Methode auch für Farbe funktioniert, betonen wir in unserer Arbeit den Anwendungsfall der Normalen-Karten, weil nicht-repetitives Rauschen ideal ist, um Oberflächendetails durch Störung der Normalen zu imitieren.

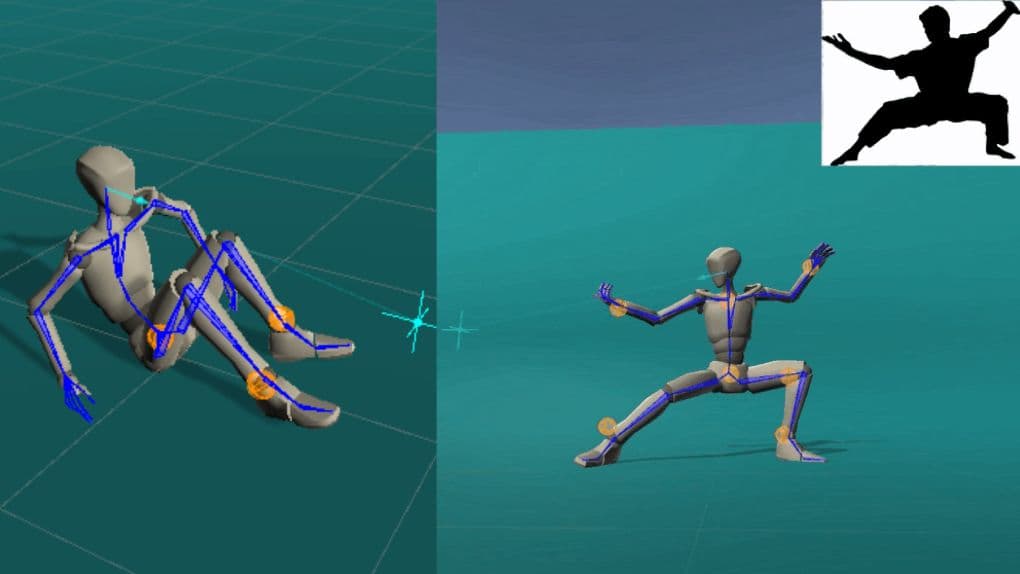

ProtoRes: Proto-Residuale Architektur für die tiefe Modellierung der menschlichen Haltung

Boris N. Oreshkin, Florent Bocquelet, Félix G. Harvey, Bay Raitt, Dominic Laflamme - ICLR 2022 (mündlich, beste 5% der angenommenen Beiträge)

Unsere Arbeit konzentriert sich auf die Entwicklung einer lernfähigen neuronalen Repräsentation der menschlichen Pose für fortschrittliche KI-gestützte Animationswerkzeuge. Wir befassen uns mit dem Problem der Konstruktion einer vollständigen statischen menschlichen Pose auf der Grundlage spärlicher und variabler Benutzereingaben (z. B. Positionen und/oder Orientierungen einer Untergruppe von Körpergelenken). Um dieses Problem zu lösen, schlagen wir eine neuartige neuronale Architektur vor, die Restverbindungen mit der prototypischen Kodierung einer teilweise spezifizierten Pose kombiniert, um eine neue vollständige Pose aus dem erlernten latenten Raum zu erstellen. Wir zeigen, dass unsere Architektur sowohl in Bezug auf die Genauigkeit als auch auf die Berechnungseffizienz besser abschneidet als eine auf Transformer basierende Basislösung. Darüber hinaus entwickeln wir eine Benutzeroberfläche zur Integration unseres neuronalen Modells in Unity, einer Echtzeit-3D-Entwicklungsplattform. Darüber hinaus stellen wir zwei neue Datensätze vor, die das Problem der Modellierung statischer menschlicher Posen auf der Grundlage hochwertiger menschlicher Bewegungserfassungsdaten repräsentieren und zusammen mit dem Modellcode veröffentlicht werden.

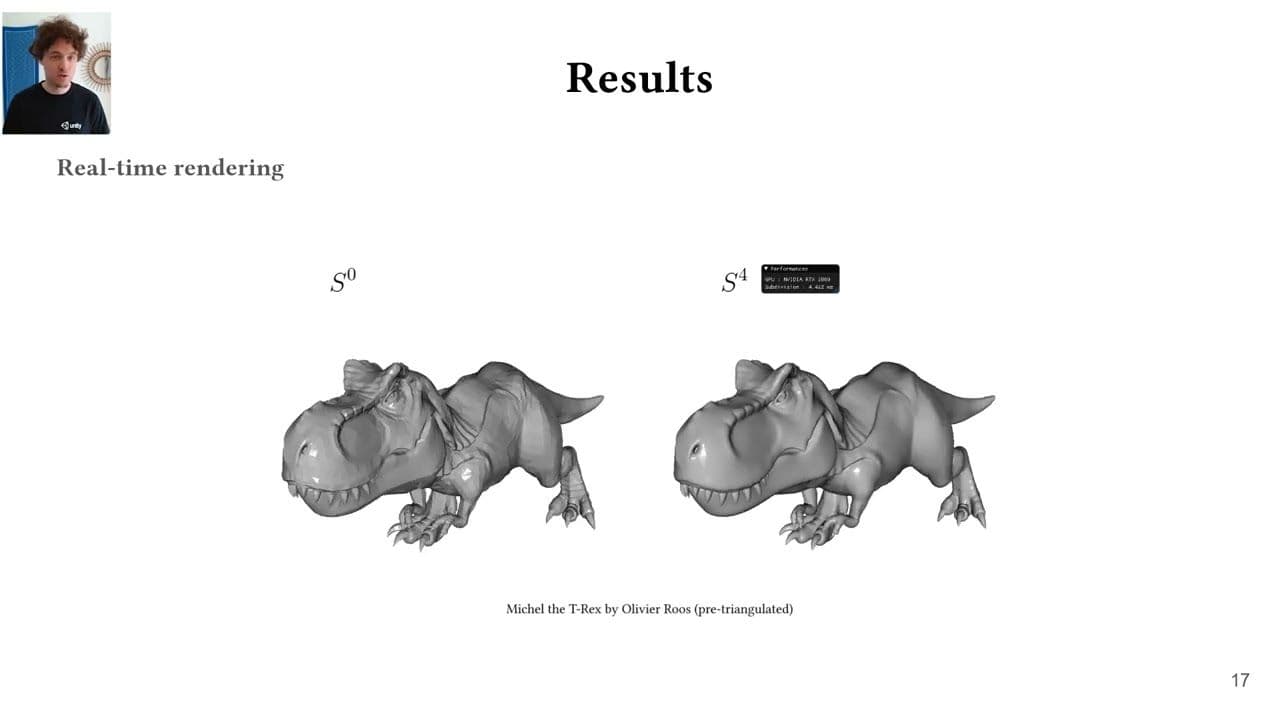

Htex: Htex: Texturierung nach Halbkanten für arbiträre Mesh-Topologien

Wilhem Barbier, Jonathan Dupuy - HPG 2022

Wir stellen die Per-Half-Edge-Texturierung (Htex) vor, eine GPU-freundliche Methode zur Texturierung beliebiger Polygonnetze ohne explizite Parametrisierung. Htex baut auf der Erkenntnis auf, dass Halbkanten eine intrinsische Triangulation für Polygonnetze kodieren, bei der jede Halbkante ein eindeutiges Dreieck mit direkter Nachbarschaftsinformation umspannt. Anstatt für jede Fläche des Eingabenetzes eine eigene Textur zu speichern, wie dies bei früheren parametrisierungsfreien Texturierungsmethoden der Fall ist, speichert Htex eine quadratische Textur für jede Halbkante und ihren Zwilling. Wir zeigen, dass dieser einfache Wechsel von Flächen zu Halbkanten zwei wichtige Eigenschaften für eine leistungsstarke parametrisierungsfreie Texturierung mit sich bringt. Erstens unterstützt Htex von Haus aus beliebige Polygone, ohne dass spezieller Code für z. B. nicht-quadratische Flächen erforderlich ist. Zweitens führt Htex zu einer unkomplizierten und effizienten GPU-Implementierung, die nur drei Texturabrufe pro Halbkante benötigt, um eine kontinuierliche Texturierung über das gesamte Netz zu erzeugen. Wir demonstrieren die Effektivität von Htex durch Rendering von Produktionsanlagen in Echtzeit.

Ein datenbasiertes Paradigma für im Voraus berechneten Strahlentransfer

Laurent Belcour, Thomas Deliot, Wilhem Barbier, Cyril Soler - HPG 2022

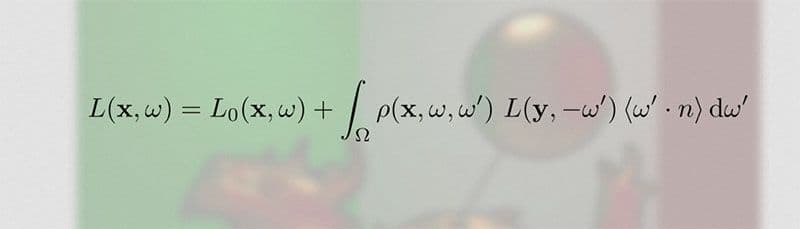

In dieser Arbeit erforschen wir einen Paradigmenwechsel zur Entwicklung von datengesteuerten Precomputed Radiance Transfer (PRT)-Methoden. Dieser Paradigmenwechsel ermöglicht es uns, die Schwierigkeiten bei der Entwicklung traditioneller PRT-Methoden zu verringern, wie z. B. die Definition einer Rekonstruktionsbasis, die Codierung eines speziellen Path Tracers zur Berechnung einer Übertragungsfunktion usw. Unser Ziel ist es, den Weg für Machine Learned Methoden zu ebnen, indem wir einen einfachen Basisalgorithmus bereitstellen. Insbesondere demonstrieren wir die Echtzeitwiedergabe von indirekter Beleuchtung in Haaren und auf Oberflächen anhand einiger weniger Messungen der direkten Beleuchtung. Wir bauen unsere Basislinie aus Paaren von Renderings mit direkter und indirekter Beleuchtung auf und verwenden nur Standardwerkzeuge wie die Singulärwertzerlegung (SVD), um sowohl die Rekonstruktionsbasis als auch die Übertragungsfunktion zu extrahieren.

Eine Half-Edge-Verfeinerungsregel für die parallele Schleifenteilung

Laurent Belcour, Thomas Deliot, Wilhem Barbier, Cyril Soler - HPG 2022

In dieser Arbeit erforschen wir einen Paradigmenwechsel zur Entwicklung von datengesteuerten Precomputed Radiance Transfer (PRT)-Methoden. Dieser Paradigmenwechsel ermöglicht es uns, die Schwierigkeiten bei der Entwicklung traditioneller PRT-Methoden zu verringern, wie z. B. die Definition einer Rekonstruktionsbasis, die Codierung eines speziellen Path Tracers zur Berechnung einer Übertragungsfunktion usw. Unser Ziel ist es, den Weg für Machine Learned Methoden zu ebnen, indem wir einen einfachen Basisalgorithmus bereitstellen. Insbesondere demonstrieren wir die Echtzeitwiedergabe von indirekter Beleuchtung in Haaren und auf Oberflächen anhand einiger weniger Messungen der direkten Beleuchtung. Wir bauen unsere Basislinie aus Paaren von Renderings mit direkter und indirekter Beleuchtung auf und verwenden nur Standardwerkzeuge wie die Singulärwertzerlegung (SVD), um sowohl die Rekonstruktionsbasis als auch die Übertragungsfunktion zu extrahieren.

Lineartransformierte Kosinuskurven in anisotropes GGX einbringen

Aakash KT, Eric Heitz, Jonathan Dupuy, P.J. Narayanan - I3D 2022

Linear transformierte Cosinusverteilungen (LTCs) sind eine Familie von Verteilungen, die dank ihrer analytischen Integrationseigenschaften für die Echtzeit-Flächenlichtschattierung verwendet werden. Moderne Spiel-Engines verwenden eine LTC-Approximation des allgegenwärtigen GGX-Modells, aber derzeit gibt es diese Approximation nur für isotropes GGX und daher wird anisotropes GGX nicht unterstützt. Während die höhere Dimensionalität an sich schon eine Herausforderung darstellt, zeigen wir, dass beim Anpassen, Nachbearbeiten, Speichern und Interpolieren von LTCs im anisotropen Fall mehrere zusätzliche Probleme auftreten. Jeder dieser Vorgänge muss sorgfältig durchgeführt werden, um Rendering-Artefakte zu vermeiden. Wir finden robuste Lösungen für jede Operation, indem wir die Invarianzeigenschaften von LTCs einführen und ausnutzen. Als Ergebnis erhalten wir eine kleine 8^4 Nachschlagetabelle, die eine plausible und artefaktfreie LTC-Annäherung an anisotrope GGX liefert und sie zu einer Echtzeit-Flächenlichtschattierung bringt.

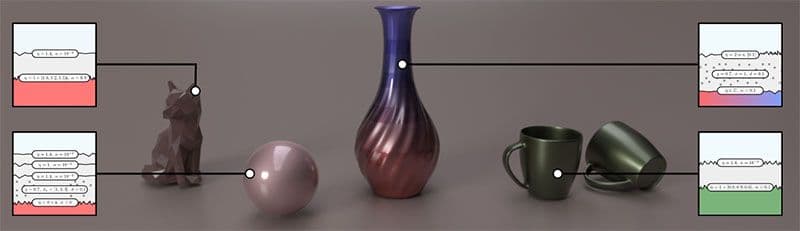

Rendering von geschichteten Materialien mit diffusen Schnittstellen

Heloise de Dinechin, Laurent Belcour - I3D 2022

In dieser Arbeit stellen wir eine neuartige Methode vor, um Lambertsche Oberflächen mit einer rauen dielektrischen Beschichtung in Echtzeit darzustellen. Wir zeigen, dass das Erscheinungsbild solcher Konfigurationen durch zwei Mikrofacetten, die für direkte bzw. indirekte Wechselwirkungen stehen, getreu dargestellt wird. Wir passen diese Keulen numerisch an die Richtungsstatistiken erster Ordnung (Energie, Mittelwert und Varianz) des Lichttransports unter Verwendung von 5D-Tabellen an und reduzieren sie mit analytischen Formen und Dimensionsreduktion auf 2D + 1D. Wir demonstrieren die Qualität unserer Methode durch die effiziente Darstellung von rauen Kunststoffen und Keramiken, die der Realität sehr nahe kommen. Darüber hinaus verbessern wir ein modernes Modell für geschichtete Materialien, um Lambertsche Grenzflächen einzubeziehen.

2021-2019

FC-GAGA: Vollständig verbundene Gated-Graph-Architektur für räumlich-zeitliche Verkehrsprognosen

Boris N. Oreshkin, Arezou Amini, Lucy Coyle, Mark J. Coates (AAAI 2021)

Die Vorhersage multivariater Zeitreihen ist ein wichtiges Problem, das im Verkehrsmanagement, bei der Konfiguration von Mobilfunknetzen und im quantitativen Finanzwesen Anwendung findet. Ein Sonderfall des Problems ergibt sich, wenn ein Diagramm zur Verfügung steht, das die Beziehungen zwischen den Zeitreihen erfasst. In diesem Papier schlagen wir eine neuartige Lernarchitektur vor, die mit den besten bestehenden Algorithmen konkurriert oder diese sogar übertrifft, ohne dass der Graph bekannt sein muss. Das Schlüsselelement der von uns vorgeschlagenen Architektur ist der lernfähige, vollständig verbundene harte Graph-Gating-Mechanismus, der den Einsatz der hochmodernen und rechnerisch effizienten Architektur für vollständig verbundene Zeitreihenprognosen in Verkehrsprognoseanwendungen ermöglicht. Experimentelle Ergebnisse für zwei öffentliche Verkehrsnetzdatensätze veranschaulichen den Wert unseres Ansatzes, und Ablationsstudien bestätigen die Bedeutung der einzelnen Elemente der Architektur.

Ein geschlitzter Wassersteinverlust für die neuronale Textursynthese

Eric Heitz, Kenneth Vanhoey, Thomas Chambon, Laurent Belcour - Erscheint in CVPR 2021

Wir befassen uns mit dem Problem der Berechnung eines Texturverlustes auf der Grundlage der Statistiken, die aus den Merkmalsaktivierungen eines für die Objekterkennung optimierten neuronalen Faltungsnetzes (z. B. VGG-19) gewonnen werden. Das zugrunde liegende mathematische Problem ist das Maß für den Abstand zwischen zwei Verteilungen im Merkmalsraum. Der Gram-Matrix-Verlust ist die allgegenwärtige Annäherung für dieses Problem, hat aber mehrere Schwächen. Unser Ziel ist es, die Sliced Wasserstein Distance als Ersatz für sie zu fördern. Es ist theoretisch bewiesen, praktisch, einfach zu implementieren und erzielt Ergebnisse, die der Textursynthese durch Optimierung oder Training generativer neuronaler Netze visuell überlegen sind.

Verbesserter Shader- und Textur-Detailgrad mit Ray Cones

Tomas Akenine-Möller, Cyril Crassin, Jakub Boksansky, Laurent Belcour, Alexey Panteleev, Oli Wright - Veröffentlicht im Journal of Computer Graphics Techniques (JCGT)

Beim Echtzeit-Raytracing ist die Texturfilterung eine wichtige Technik zur Verbesserung der Bildqualität. Aktuelle Spiele, wie z. B. Minecraft mit RTX auf Windows 10, verwenden Strahlenkegel, um Texturfilter-Footprints zu bestimmen. In diesem Beitrag stellen wir mehrere Verbesserungen des Ray-Cones-Algorithmus vor, die die Bildqualität und Leistung verbessern und die Übernahme in Spiele-Engines erleichtern. Wir zeigen, dass die Gesamtzeit pro Frame in einem GPU-basierten Path Tracer um etwa 10 % gesenkt werden kann, und wir stellen eine Public-Domain-Implementierung zur Verfügung.

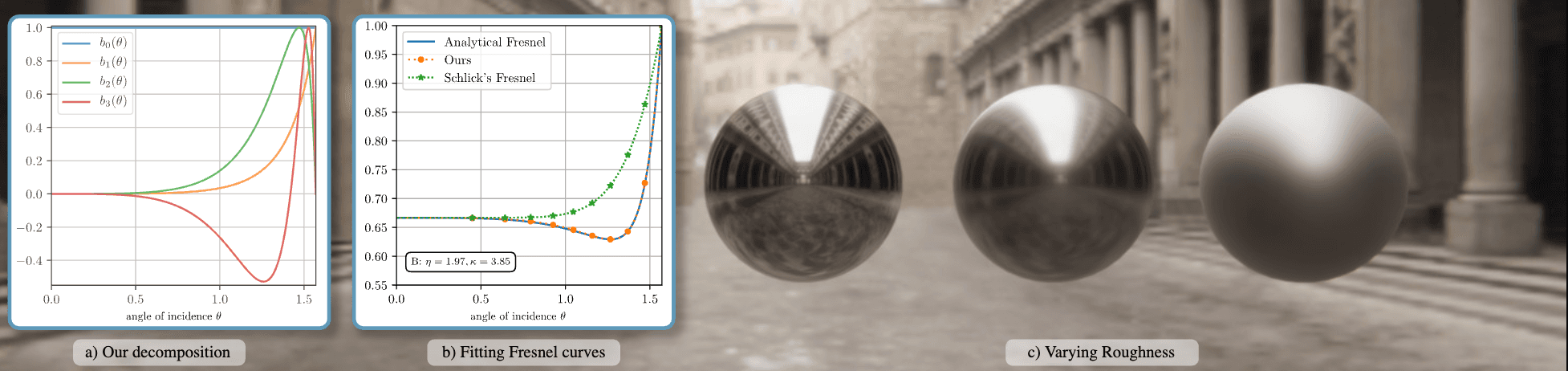

Genaues Fresnel für Echtzeit-Rendering: eine präintegrable Dekomposition

Laurent Belcour, Megane Bati, Pascal Barla - Veröffentlicht in ACM SIGGRAPH 2020 Talks and Courses

Wir stellen ein neues approximatives Fresnel-Reflexionsmodell vor, das die genaue Reproduktion der Bodenreflektion in Echtzeit-Rendering-Engines ermöglicht. Unsere Methode basiert auf einer empirischen Zerlegung des Raums möglicher Fresnel-Kurven. Es ist kompatibel mit der Vorintegration von bildbasierter Beleuchtung und Flächenlichtern, die in Echtzeit-Engines verwendet werden. Unsere Arbeit ermöglicht die Verwendung einer Reflexionsparametrisierung [Gulbrandsen 2014], die bisher auf das Offline-Rendering beschränkt war.

Gleichzeitige Binärbäume

Jonathan Dupuy - HPG 2020

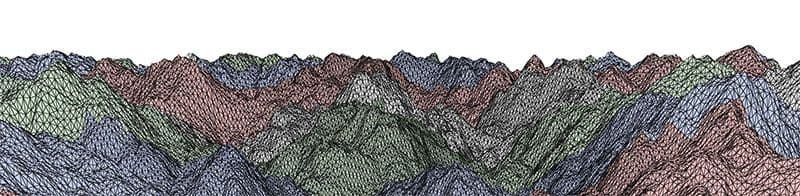

Wir stellen den concurrent binary tree (CBT) vor, eine neuartige nebenläufige Darstellung, um beliebige binäre Bäume parallel aufzubauen und zu aktualisieren. Grundsätzlich besteht unsere Darstellung aus einem binären Heap, d.h. einem 1D-Array, das explizit den Summenreduktionsbaum eines Bitfeldes speichert. In diesem Bitfeld stellt jedes einwertige Bit einen Blattknoten des vom CBT kodierten Binärbaums dar, den wir algorithmisch mit Hilfe einer Binärsuche über die Summenreduktion lokalisieren. Wir zeigen, dass diese Konstruktion es ermöglicht, bis auf einen Thread pro Blattknoten herunterzugehen, und dass diese Threads wiederum durch einfache bitweise Operationen über das Bitfeld gleichzeitig Knoten sicher teilen und/oder entfernen können. Der praktische Nutzen von CBTs liegt in ihrer Fähigkeit, binärbaumbasierte Algorithmen mit parallelen Prozessoren zu beschleunigen. Um diese Behauptung zu untermauern, nutzen wir unsere Darstellung zur Beschleunigung eines auf der längsten Kante basierenden Algorithmus, der adaptive Geometrien für großflächige Terrains vollständig auf dem Grafikprozessor berechnet und rendert. Bei diesem speziellen Algorithmus beschleunigt die CBT die Verarbeitungsgeschwindigkeit linear mit der Anzahl der Prozessoren.

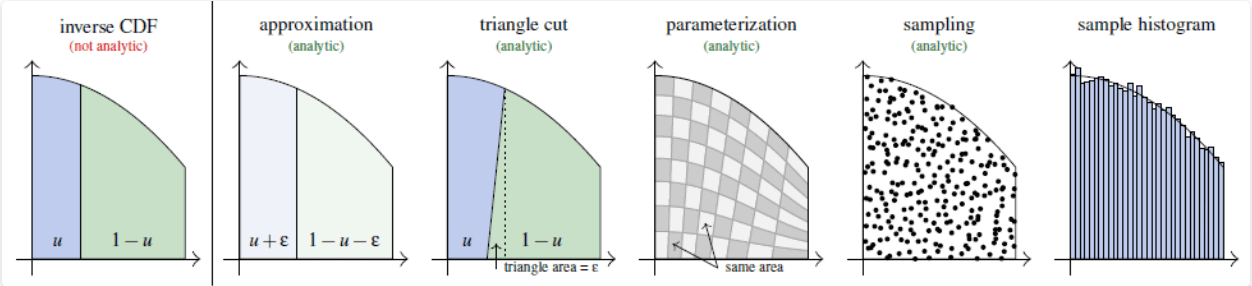

Kann die CDF nicht invertiert werden? Die Dreiecksschnitt-Parametrisierung der Region unter der Kurve

Eric Heitz - EGSR 2020

Wir stellen eine exakte, analytische und deterministische Methode für Stichprobendichten vor, deren kumulative Verteilungsfunktionen (CDFs) nicht analytisch invertiert werden können. In der Tat wird die inverse CDF-Methode häufig als der richtige Weg für die Probenahme von ungleichmäßigen Dichten angesehen. Wenn die CDF nicht analytisch invertierbar ist, sind die typischen Ausweichlösungen entweder annähernd, numerisch oder nicht-deterministisch, wie z. B. Annahme-Ablehnung. Um dieses Problem zu lösen, zeigen wir, wie man eine analytische, flächenerhaltende Parametrisierung der Region unter der Kurve der Zieldichte berechnet. Wir verwenden es, um Zufallspunkte zu erzeugen, die gleichmäßig unter der Kurve der Zieldichte verteilt sind und deren Abszissen somit mit der Zieldichte verteilt sind. Technisch gesehen besteht unsere Idee darin, eine annähernde analytische Parametrisierung zu verwenden, deren Fehler geometrisch als ein einfach auszuschneidendes Dreieck dargestellt werden kann. Diese Dreiecksschnitt-Parametrisierung führt zu exakten und analytischen Lösungen für Stichprobenprobleme, die vermutlich nicht analytisch lösbar waren.

Rendering von geschichteten Materialien mit anisotropen Grenzflächen

Philippe Weier, Laurent Belcour - Veröffentlicht im Journal of Computer Graphics Techniques (JCGT)

Wir stellen eine leichtgewichtige und effiziente Methode zur Darstellung geschichteter Materialien mit anisotropen Grenzflächen vor. Unsere Arbeit erweitert unser zuvor veröffentlichtes statistisches Rahmenwerk, um anisotrope Mikrofacettenmodelle zu behandeln. Eine wichtige Erkenntnis unserer Arbeit ist, dass die BRDF-Keulen einer anisotropen GGX-Verteilung, wenn sie auf die Tangentialebene projiziert werden, gut durch ellipsoidische Verteilungen approximiert werden, die mit dem tangentialen Rahmen ausgerichtet sind: ihre Kovarianzmatrix ist in diesem Raum diagonal. Wir machen uns diese Eigenschaft zunutze und führen den isotropen Schichtalgorithmus für jede Anisotropieachse unabhängig durch. Außerdem aktualisieren wir die Abbildung der Rauheit auf die Richtungsvarianz und die Bewertung des durchschnittlichen Reflexionsgrads, um die Anisotropie zu berücksichtigen.

Integration und Simulation von bivariaten projektiven-Cauchy-Verteilungen in beliebigen polygonalen Domänen

Jonathan Dupuy, Laurent Belcour & Eric Heitz - Technischer Bericht 2019

Betrachten Sie eine gleichförmige Variante auf der oberen Halbkugel der Dimension d. Es ist bekannt, dass die geradlinige Projektion durch den Mittelpunkt der Einheitskugel auf die darüber liegende Ebene diese Variable gemäß einer d-dimensionalen projektiven-Cauchy-Verteilung verteilt. In dieser Arbeit nutzen wir die Geometrie dieser Konstruktion in der Dimension d=2, um neue Eigenschaften für die bivariate projektive-Cauchy-Verteilung abzuleiten. Insbesondere zeigen wir anhand geometrischer Intuitionen, dass die Integration und Simulation einer bivariaten projektiven-Cauchy-Verteilung in einem beliebigen Gebiet mit der Messung bzw. Abtastung des Raumwinkels übereinstimmt, den die Geometrie dieses Gebiets vom Ursprung der Einheitskugel aus gesehen bildet. Um dieses Ergebnis praktisch anwendbar zu machen, z.B. für die Erzeugung von abgeschnittenen Varianten der bivariaten projektiven-Cauchy-Verteilung, erweitern wir es in zweierlei Hinsicht. Zunächst wird eine Verallgemeinerung auf Cauchy-Verteilungen vorgenommen, die durch Orts-Skalen-Korrelationskoeffizienten parametrisiert sind. Zweitens bieten wir eine Spezialisierung auf polygonale Bereiche an, die zu geschlossenen Formeln führt. Wir stellen eine vollständige MATLAB-Implementierung für den Fall von Dreiecksdomänen zur Verfügung und erörtern kurz den Fall von elliptischen Domänen und wie unsere Ergebnisse auf bivariate Student-Verteilungen erweitert werden können.

Auf Oberflächengradienten basierendes Bump Mapping Framework

Morten Mikkelsen 2020

In dieser Veröffentlichung wird ein neues Framework für das Layering/Compositing von Bump Maps/Normal Maps mit Unterstützung sowohl für mehrere Sets von Texturkoordinaten als auch für prozedural generierte Texturkoordinaten und Geometrie empfohlen. Darüber hinaus bieten wir geeignete Unterstützung und Integration für Bumpmaps, die über Volumen wie Decal-Projektoren, triplanare Projektionen oder rauschbasierten Funktionen definiert sind.

Multi-Stylisierung von Videospielen in Echtzeit unter Berücksichtigung von G-Buffer-Informationen

Adèle Saint-Denis, Kenneth Vanhoey, Thomas Deliot HPG 2019

Wir untersuchen, wie man die Vorteile moderner neuronaler Stilübertragungstechniken nutzen kann, um den Stil von Videospielen zur Laufzeit zu verändern. Die neuesten neuronalen Netze für die Stilübertragung sind vortrainiert und ermöglichen die schnelle Übertragung eines beliebigen Stils zur Laufzeit. Ein einziger Stil gilt jedoch global für das gesamte Bild, während wir dem Nutzer gerne feinere Gestaltungsmöglichkeiten bieten würden. In dieser Arbeit erlauben wir dem Benutzer, Stile (mittels eines Stilbildes) verschiedenen physikalischen Größen zuzuordnen, die sich im G-Buffer einer Deferred Rendering Pipeline befinden, wie Tiefe, Normalen oder Objekt-ID. Unser Algorithmus interpoliert diese Stile dann fließend entsprechend der zu rendernden Szene: z. B. ergibt sich ein anderer Stil für verschiedene Objekte, Tiefen oder Ausrichtungen.

2019-2018

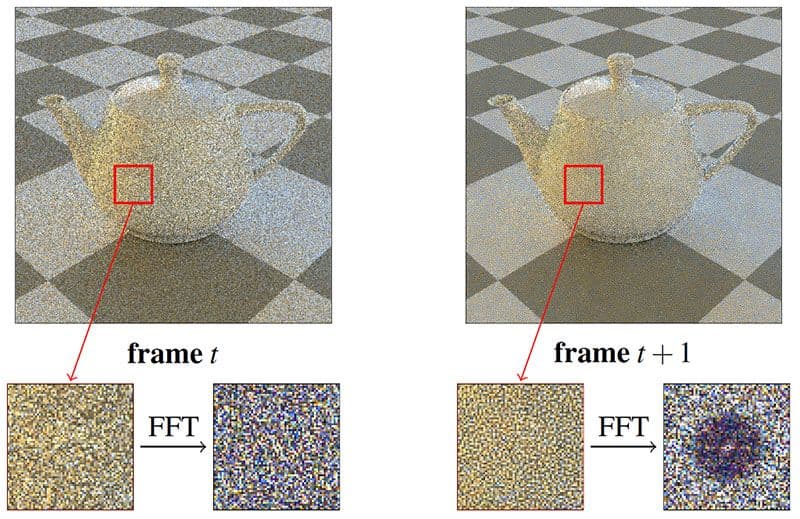

Verteilung von Monte-Carlo-Fehlern als blaues Rauschen im Bildschirmraum durch Permutation von Pixel Seeds zwischen Frames

Eric Heitz, Laurent Belcour – EGSR 2019

Wir führen einen Sampler ein, der Pro-Pixel-Sample generiert und dank zwei wesentlicher Eigenschaften in Zusammenhang mit den erzeugten Monte-Carlo-Fehlern eine hohe Grafikqualität erreicht. Erstens ist die Sequenz jedes Pixels eine Owen-verschlüsselte Sobol-Sequenz, die modernste Konvergenzeigenschaften aufweist. Die Monte-Carlo-Fehler haben also eine geringe Größenordnung. Zweitens werden diese Fehler als blaues Rauschen über die Bildschirmfläche verteilt. Das macht sie visuell noch angenehmer. Unser Probenehmer ist leicht und schnell. Wir implementieren ihn mit einer kleinen Struktur und zwei XOR-Operationen. Unsere ergänzenden Materialien bieten Vergleiche mit vorherigen Arbeiten für verschiedene Szenen und Sample-Zahlen.

Ein Sampler mit geringer Diskrepanz, der Monte-Carlo-Fehler als blaues Rauschen im Bildschirmraum verteilt

Eric Heitz, Laurent Belcour – ACM SIGGRAPH Talk 2019

Wir führen einen Sampler ein, der Pro-Pixel-Sample generiert und dank zwei wesentlicher Eigenschaften in Zusammenhang mit den erzeugten Monte-Carlo-Fehlern eine hohe Grafikqualität erreicht. Erstens ist die Sequenz jedes Pixels eine Owen-verschlüsselte Sobol-Sequenz, die modernste Konvergenzeigenschaften aufweist. Die Monte-Carlo-Fehler haben also eine geringe Größenordnung. Zweitens werden diese Fehler als blaues Rauschen über die Bildschirmfläche verteilt. Das macht sie visuell noch angenehmer. Unser Sampler ist schlank und schnell. Wir implementieren ihn mit einer kleinen Struktur und zwei XOR-Operationen. Unsere ergänzenden Materialien bieten Vergleiche mit vorherigen Arbeiten für verschiedene Szenen und Sample-Zahlen.

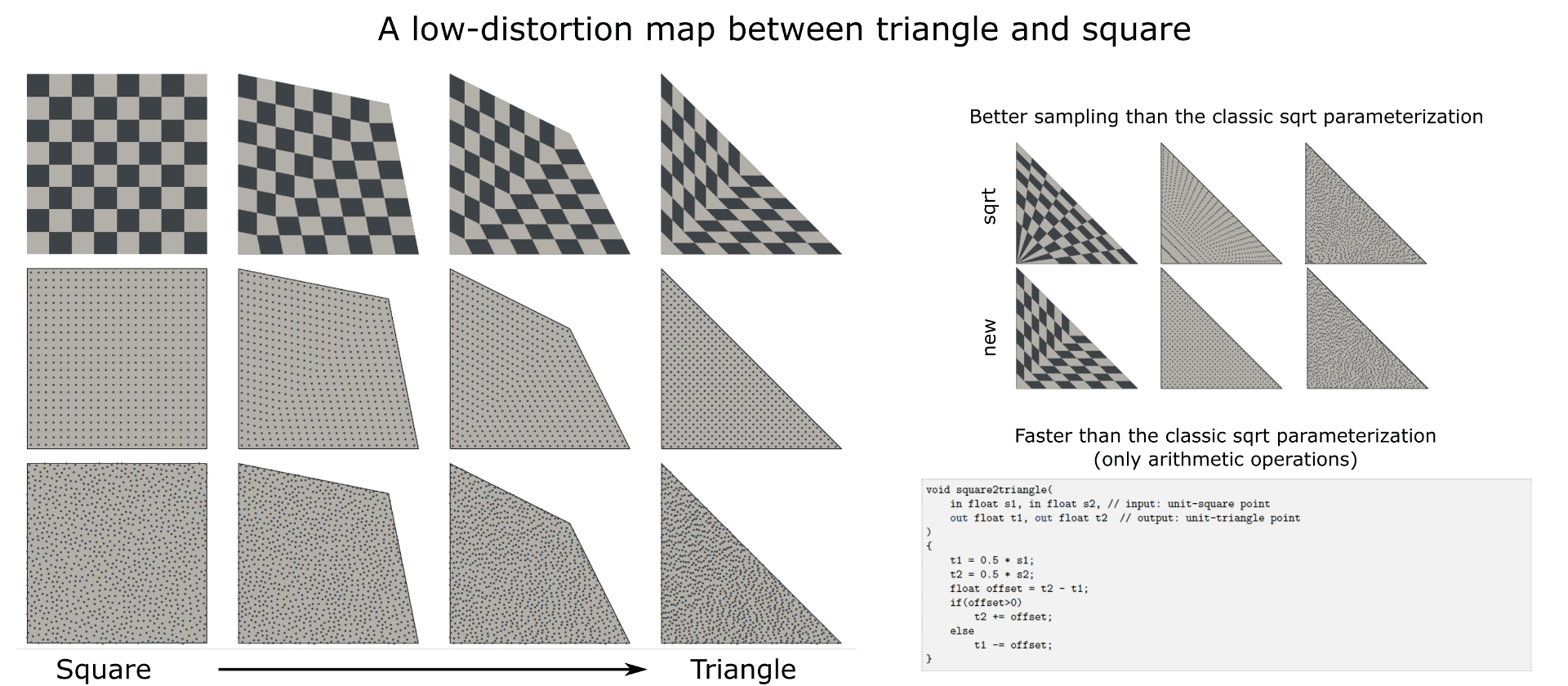

Eine verzerrungsarme Karte zwischen Dreieck und Quadrat

Eric Heitz – Tech Report 2019

Wir führen eine verzerrungsarme Karte zwischen Dreieck und Quadrat ein. Diese Abbildung führt zu einer flächenerhaltenden Parametrisierung, die für Stichproben von Zufallspunkten mit gleichmäßiger Dichte in beliebigen Dreiecken verwendet werden kann. Diese Parametrisierung bietet zwei Vorteile im Vergleich zur Quadratwurzel-Parametrisierung, die normalerweise für Dreiecksstichproben verwendet wird. Erstens weist es geringere Verzerrungen auf und bewahrt die Eigenschaften des blauen Rauschens der Eingangsproben besser. Zweitens beruht die Berechnung nur auf arithmetischen Operationen (+, *), wodurch sie schneller ausgewertet werden kann.

Abtasten der GGX-Verteilung der sichtbaren Normalen

Eric Heitz - JCGT 2018

Importance Sampling von Mikrofacetten-BSDFs unter Verwendung ihrer Verteilung der sichtbaren Normalen (VNDF) führt zu einer signifikanten Varianzreduzierung beim Monte-Carlo-Rendering. In diesem Artikel beschreiben wir eine effiziente und exakte Sampling-Routine für die VNDF der GGX-Mikrofacettenverteilung. Diese Routine macht sich die Eigenschaft zunutze, dass GGX die Verteilung der Normalen eines Ellipsoidstumpfes ist und die Abtastung der GGX-VNDF einer Abtastung der 2D-Projektion dieses Ellipsoidstumpfes entspricht. Zu diesem Zweck vereinfachen wir das Problem, indem wir die lineare Transformation verwenden, die das abgeschnittene Ellipsoid auf eine Halbkugel abbildet. Da bei linearen Transformationen die Einheitlichkeit der projizierten Flächen erhalten bleibt, führt die Probenahme in der Halbkugelkonfiguration und die Rücktransformation der Proben in die Ellipsoidkonfiguration zu gültigen Proben aus der GGX VNDF.

Analytische Berechnung eines Raumwinkels, der von einem beliebig gesetzten Ellipsoid bei einer Punktquelle geschnitten wird

Eric Heitz - Nukleare Instrumente und Methoden in der physikalischen Forschung 2018

Wir stellen eine geometrische Methode zur Berechnung einer Ellipse vor, die den gleichen Raumwinkelbereich wie ein beliebig positioniertes Ellipsoid einnimmt. Mit dieser Methode können wir bestehende analytische Raumwinkelberechnungen von Ellipsen auf Ellipsoide ausweiten. Unsere Idee besteht darin, eine lineare Transformation auf das Ellipsoid anzuwenden, so dass es in eine Kugel umgewandelt wird, aus der eine Scheibe berechnet werden kann, die denselben Raumwinkelbereich abdeckt. Wir zeigen, dass wir durch Anwendung der inversen linearen Transformation auf diese Scheibe eine Ellipse erhalten, die den gleichen Raumwinkelbereich wie das Ellipsoid einnimmt. Wir stellen eine MATLAB-Implementierung unseres Algorithmus zur Verfügung und validieren ihn numerisch.

Ein Hinweis auf Spurlängen-Stichproben mit nicht-exponentiellen Verteilungen

Eric Heitz, Laurent Belcour - Tech Report 2018

Beim Track-Length-Sampling werden Zufallsintervalle entsprechend einer Abstandsverteilung ausgewählt. Das bedeutet, dass anstelle der Stichprobe einer punktuellen Entfernung aus der Entfernungsverteilung ein Intervall möglicher Entfernungen erzeugt wird, das korrekt ist, wenn die Erwartung der Intervalle der Zielentfernungsverteilung entspricht. Mit anderen Worten: Die Mittelwertbildung über alle Stichprobenintervalle sollte mit zunehmender Anzahl der Intervalle gegen die Abstandsverteilung konvergieren. In dieser Anmerkung betonen wir, dass die Entfernungsverteilung, die für die Stichprobe der punktuellen Entfernungen verwendet wird, und die Verteilung der Streckenlänge, die für die Stichprobe der Intervalle verwendet wird, im Allgemeinen nicht dieselbe ist. Dieser Unterschied kann überraschen, denn unseres Wissens nach wurde das Track-Length-Sampling hauptsächlich im Rahmen der Transporttheorie untersucht, wo die Entfernungsverteilung typischerweise exponentiell ist: In diesem speziellen Fall sind die Entfernungsverteilung und die Track-Length-Verteilung zufällig beide dieselbe Exponentialverteilung. Sie sind jedoch im Allgemeinen nicht dasselbe, wenn die Entfernungsverteilung nicht exponentiell ist.

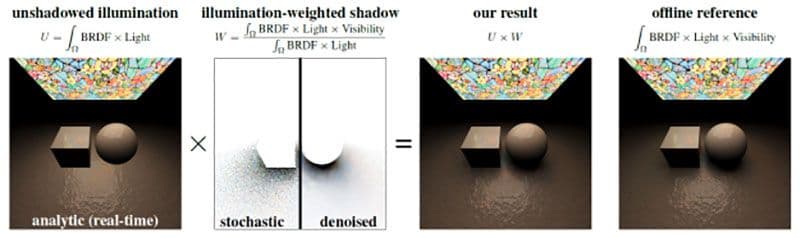

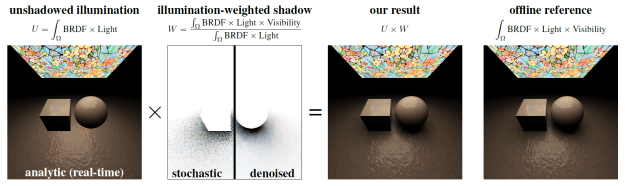

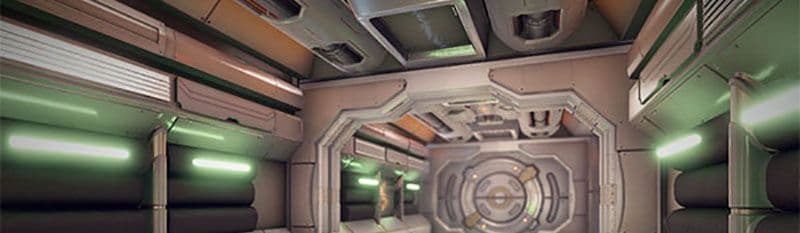

Kombination von analytischer Direktbeleuchtung und stochastischem Schattenwurf

Eric Heitz, Stephen Hill (Lucasfilm), Morgan McGuire (NVIDIA) - I3D 2018 (Kurzvortrag) (Auszeichnung für den besten Vortrag)

In dieser Arbeit schlagen wir einen Verhältnisschätzer für die Gleichung der direkten Beleuchtung vor, der es uns ermöglicht, analytische Beleuchtungstechniken mit stochastischen raytraced Schatten zu kombinieren und dabei die Korrektheit zu erhalten. Unser Hauptbeitrag besteht darin, zu zeigen, dass die verschattete Beleuchtung in das Produkt aus der nicht verschatteten Beleuchtung und dem beleuchtungsgewichteten Schatten aufgeteilt werden kann. Diese Terme können separat berechnet werden - möglicherweise mit unterschiedlichen Techniken - ohne die Genauigkeit des Endergebnisses, das sich aus ihrem Produkt ergibt, zu beeinträchtigen. Diese Formulierung erweitert den Nutzen analytischer Beleuchtungsverfahren für Raytracing-Anwendungen, die bisher vermieden wurden, weil sie keine Schatten berücksichtigen. Wir verwenden solche Methoden, um scharfe und rauschfreie Schattierungen im schattenlosen Beleuchtungsbild zu erhalten, und wir berechnen das gewichtete Schattenbild mit stochastischem Raytracing. Die Beschränkung der stochastischen Auswertung auf das gewichtete Schattenbild hat den Vorteil, dass das Endergebnis nur in den Schatten Rauschen aufweist. Außerdem entrauschen wir die Schatten getrennt von der Beleuchtung, so dass selbst bei aggressiver Entrauschung nur die Schatten verwischt werden, während die hochfrequenten Schattendetails (Texturen, Normal Maps usw.) erhalten bleiben.

Nicht-periodische Kacheln von prozeduralen Rauschfunktionen

Aleksandr Kirillov - HPG 2018

Prozedurale Rauschfunktionen finden in der Computergrafik zahlreiche Anwendungen, die von der Textursynthese über die Simulation atmosphärischer Effekte bis hin zur Spezifikation der Landschaftsgeometrie reichen. Rauschen kann entweder vorberechnet und in einer Textur gespeichert oder direkt zur Laufzeit der Anwendung ausgewertet werden. Diese Wahl bietet einen Kompromiss zwischen Bildvarianz, Speicherverbrauch und Leistung.

Erweiterte Kachelalgorithmen können verwendet werden, um visuelle Wiederholungen zu verringern. Mit Wang-Kacheln kann eine Ebene auf nicht-periodische Weise gekachelt werden, wobei ein relativ kleiner Satz von Texturen verwendet wird. Die Kacheln können in einer einzigen Texturkarte angeordnet werden, damit die GPU die Hardwarefilterung nutzen kann.

In diesem Beitrag stellen wir Änderungen an mehreren beliebten prozeduralen Rauschfunktionen vor, die direkt Texturkarten mit dem kleinsten vollständigen Wang-Kachelsatz erzeugen. Die in dieser Arbeit vorgestellten Erkenntnisse ermöglichen eine nicht-periodische Kachelung dieser Rauschfunktionen und darauf basierender Texturen, sowohl zur Laufzeit als auch als Vorverarbeitungsschritt. Diese Erkenntnisse ermöglichen es auch, die Wiederholung von rauschbasierten Effekten in computergenerierten Bildern mit geringen Leistungskosten zu verringern, während der Speicherverbrauch beibehalten oder sogar reduziert wird.

Leistungsstarkes By-Example-Rauschen unter Verwendung eines Histogramm-erhaltenden Überblendungsoperators

Eric Heitz, Fabrice Neyret (Inria) - HPG 2018 (Best Paper Award)

Wir schlagen einen neuen Rauschalgorithmus vor, der ein kleines Beispiel einer stochastischen Textur als Eingabe nimmt und eine unendliche Ausgabe mit demselben Aussehen synthetisiert. Es funktioniert mit jeder Art von zufälligen Eingaben sowie mit vielen nicht zufälligen Eingaben, die stochastisch und nicht periodisch sind, typischerweise natürliche Texturen wie Moos, Granit, Sand, Rinde usw. Unser Algorithmus erzielt qualitativ hochwertige Ergebnisse, die mit den modernsten verfahrenstechnischen Rauschverfahren vergleichbar sind, ist aber mehr als 20 Mal schneller.

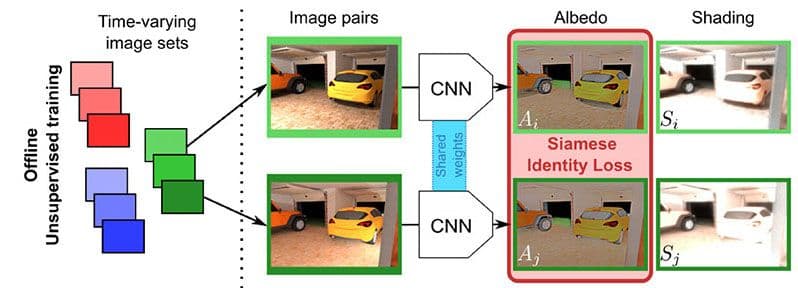

Unüberwachte tiefe Einzelbild-Intrinsic-Zerlegung mit beleuchtungsabhängigen Bildsequenzen

Louis Lettry (ETH Zürich), Kenneth Vanhoey, Luc Van Gool (ETH Zürich) - Pacific Graphics 2018 / Computer Graphics Forum

Die Intrinsische Dekomposition zerlegt eine fotografierte Szene in Albedo und Schattierung. Durch das Entfernen von Schattierungen lassen sich Bilder "entzücken", die dann in virtuell neu beleuchteten Szenen wiederverwendet werden können. Wir schlagen eine unüberwachte Lernmethode vor, um dieses Problem zu lösen.

Neuere Techniken verwenden überwachtes Lernen: Sie erfordern einen großen Satz bekannter Zerlegungen, die schwer zu erhalten sind. Stattdessen trainieren wir mit unkommentierten Bildern, indem wir Zeitrafferaufnahmen von statischen Webcams verwenden. Wir nutzen die Annahme, dass die Albedo per Definition statisch ist und die Schattierung mit der Beleuchtung variiert. Wir übertragen dies in ein Siamesisches Training für Deep Learning.

2018-2016

Effizientes Rendering geschichteter Materialien unter Verwendung einer atomaren Zersetzung mit statistischen Operatoren

Laurent Belcour - ACM SIGGRAPH 2018

Wir leiten einen neuen Rahmen für die effiziente Analyse und Berechnung des Lichttransports in geschichteten Materialien ab. Unsere Herleitung besteht aus zwei Schritten. Zunächst zerlegen wir den Lichttransport in eine Reihe von atomaren Operatoren, die auf die Richtungsstatistik wirken. Konkret bestehen unsere Operatoren aus Reflexion, Brechung, Streuung und Absorption, deren Kombinationen ausreichen, um die Statistik der mehrfachen Streuung von Licht in geschichteten Strukturen zu beschreiben. Wir zeigen, dass die ersten drei Richtungsmomente (Energie, Mittelwert und Varianz) bereits eine genaue Zusammenfassung liefern. Zweitens erweitern wir die Additions-Doubling-Methode, um beliebige Kombinationen solcher Operatoren effizient zu unterstützen. Bei der Schattierung bilden wir die Richtungsmomente auf BSDF-Keulen ab. Wir validieren, dass die resultierende BSDF der Bodenwahrheit in einer leichten und effizienten Form sehr nahe kommt. Im Gegensatz zu früheren Methoden unterstützen wir eine beliebige Anzahl von texturierten Schichten und demonstrieren ein praktisches und genaues Rendering von geschichteten Materialien sowohl mit einer Offline- als auch einer Echtzeit-Implementierung, die frei von Vorberechnungen pro Material sind.

Eine adaptive Parametrisierung für Materialerfassung und Rendering

Jonathan Dupuy und Wenzel Jakob (EPFL) - ACM SIGGRAPH Asia 2018

Einer der wichtigsten Bestandteile jedes physikalisch basierten Rendering-Systems ist eine detaillierte Spezifikation, die die Interaktion von Licht und Materie aller in einer Szene vorhandenen Materialien charakterisiert, typischerweise über die bidirektionale Reflexionsverteilungsfunktion (BRDF). Trotz ihrer Nützlichkeit ist der Zugang zu realen BRDF-Datensätzen nach wie vor begrenzt: Dies liegt daran, dass für die Messungen ein vierdimensionaler Bereich mit ausreichender Auflösung gescannt werden muss, ein mühsamer und oft nicht durchführbarer zeitaufwändiger Prozess. Wir schlagen eine neue Parametrisierung vor, die sich automatisch an das Verhalten eines Materials anpasst und die zugrundeliegende 4D-Domäne so verformt, dass der größte Teil des Volumens auf Regionen entfällt, in denen die BRDF nicht vernachlässigbare Werte annimmt, während irrelevante Regionen stark komprimiert werden. Diese Anpassung erfordert nur eine kurze 1D- oder 2D-Messung der retroreflektierenden Eigenschaften des Materials. Unsere Parametrisierung ist insofern vereinheitlicht, als sie mehrere Schritte kombiniert, die bisher Zwischenschritte bei der Datenkonvertierung erforderten: dieselbe Abbildung kann gleichzeitig für die BRDF-Erfassung und -Speicherung verwendet werden, und sie unterstützt die effiziente Erzeugung von Monte-Carlo-Beispielen.

Stochastische Schatten

Eric Heitz, Stephen Hill (Lucasfilm), Morgan McGuire (NVIDIA)

In dieser Arbeit schlagen wir einen Verhältnisschätzer für die Gleichung der direkten Beleuchtung vor, der es uns ermöglicht, analytische Beleuchtungstechniken mit stochastischen raytraced Schatten zu kombinieren und dabei die Korrektheit zu erhalten. Unser Hauptbeitrag besteht darin, zu zeigen, dass die verschattete Beleuchtung in das Produkt aus der nicht verschatteten Beleuchtung und dem beleuchtungsgewichteten Schatten aufgeteilt werden kann. Diese Terme können separat berechnet werden - möglicherweise mit unterschiedlichen Techniken - ohne die Genauigkeit des Endergebnisses, das sich aus ihrem Produkt ergibt, zu beeinträchtigen.

Diese Formulierung erweitert den Nutzen analytischer Beleuchtungsverfahren für Raytracing-Anwendungen, die bisher vermieden wurden, weil sie keine Schatten berücksichtigen. Wir verwenden solche Methoden, um scharfe und rauschfreie Schattierungen im schattenlosen Beleuchtungsbild zu erhalten, und wir berechnen das gewichtete Schattenbild mit stochastischem Raytracing. Die Beschränkung der stochastischen Auswertung auf das gewichtete Schattenbild hat den Vorteil, dass das Endergebnis nur in den Schatten Rauschen aufweist. Außerdem entrauschen wir die Schatten getrennt von der Beleuchtung, so dass selbst bei aggressiver Entrauschung nur die Schatten verwischt werden, während die hochfrequenten Schattendetails (Texturen, Normal Maps usw.) erhalten bleiben.

Adaptive GPU-Tesselierung mit Compute Shadern

Jad Khoury, Jonathan Dupuy und Christophe Riccio - GPU Zen 2

GPU-Rasterizer sind am effizientesten, wenn Primitive in mehr als ein paar Pixel hineinragen. Unterhalb dieser Grenze beginnt der Z-Puffer mit Aliasing, und die Schattierungsrate nimmt drastisch ab [Riccio 12]. Dies macht das Rendern geometrisch komplexer Szenen zu einer Herausforderung, da jedes Polygon in mittlerer Entfernung auf Subpixelgröße projiziert wird. Um solche Subpixel-Projektionen zu minimieren, besteht eine einfache Lösung darin, grobe Netze prozedural zu verfeinern, wenn sie sich der Kamera nähern. In diesem Kapitel geht es darum, eine solche prozedurale Verfeinerungstechnik für beliebige Polygonnetze abzuleiten.

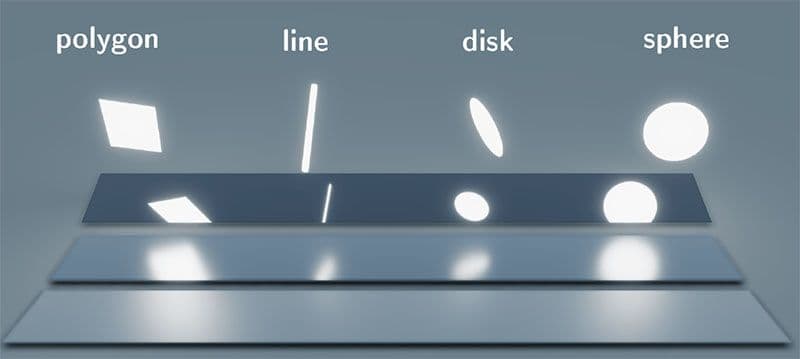

Linien- und Scheiben-Licht-Schatten-Effekte in Echtzeit mit linear transformiertem Cosinus

Eric Heitz (Unity Technologies) und Stephen Hill (Lucasfilm) - ACM SIGGRAPH Kurse 2017

Wir haben kürzlich eine neue Echtzeit-Flächenlicht-Schattierungstechnik eingeführt, die für Lichter mit polygonalen Formen geeignet ist. In diesem Vortrag erweitern wir dieses Flächenbeleuchtungskonzept, um neben Polygonen auch Lichter in Form von Linien, Kugeln und Scheiben zu unterstützen.

- Folien

- Demo-Code

- WebGL-Demo für Quad-, Linien- und Scheibenlicht

Mikrofacetten-Normal-Mapping für robustes Monte Carlo Path Tracing

Vincent Schüssler (KIT), Eric Heitz (Unity Technologies), Johannes Hanika (KIT) und Carsten Dachsbacher (KIT) - ACM SIGGRAPH ASIA 2017

Normal Mapping imitiert visuelle Details auf Oberflächen durch die Verwendung von gefälschten Schattierungsnormalen. Das sich daraus ergebende Oberflächenmodell ist jedoch geometrisch unmöglich, und die Normalenabbildung wird daher oft als ein grundlegend fehlerhafter Ansatz mit unvermeidlichen Problemen für die Monte-Carlo-Bahnverfolgung angesehen: Sie bricht entweder das Erscheinungsbild (schwarze Streifen, Energieverlust) oder den Integrator (unterschiedlicher Vorwärts- und Rückwärtstransport von Licht). In diesem Beitrag stellen wir eine alternative Methode vor, mit der geometrische Details gefälscht werden können, ohne dass die Robustheit der Monte-Carlo-Pfadverfolgung beeinträchtigt wird, so dass diese Probleme nicht auftreten.

Ein sphärisches, cap-erhaltendes Parametrisierungsverfahren für sphärische Verteilung

Jonathan Dupuy, Eric Heitz und Laurent Belcour - ACM SIGGRAPH 2017

Wir führen eine neuartige Parametrisierung für kugelförmige Verteilungen ein, die auf einem Punkt im Inneren der Kugel basiert, den wir Pivot nennen. Der Drehpunkt dient als Mittelpunkt einer geradlinigen Projektion, die Raumwinkel auf die gegenüberliegende Seite der Kugel abbildet. Indem wir sphärische Verteilungen auf diese Weise transformieren, leiten wir neuartige parametrische sphärische Verteilungen ab, die mit Hilfe einfacher, geschlossener Formausdrücke aus den ursprünglichen Verteilungen ausgewertet und nach Wichtigkeit gesampelt werden können. Außerdem beweisen wir, dass, wenn die ursprüngliche Verteilung über eine kugelförmige Kappe abgetastet und/oder integriert werden kann, dies auch für die transformierte Verteilung gilt. Wir nutzen die Eigenschaften unserer Parametrisierung, um effiziente sphärische Beleuchtungstechniken sowohl für Echtzeit- als auch Offline-Rendering abzuleiten. Unsere Techniken sind robust, schnell und einfach zu implementieren und erreichen eine Qualität, die der bisheriger Arbeiten überlegen ist.

Eine praktische Erweiterung der Mikrofacetten-Theorie für die Modellierung variierender Schillereffekte

Laurent Belcour (Unity), Pascal Barla (Inria) - ACM SIGGRAPH 2017

Die Dünnschicht-Irisierung ermöglicht es, das Aussehen von Leder zu reproduzieren. Diese Theorie erfordert jedoch spektrale Rendering-Engines (wie Maxwell Render), um die Veränderung des Aussehens in Abhängigkeit vom Blickwinkel (bekannt als Goniochromatismus) korrekt zu integrieren. Dies ist auf Aliasing im Spektralbereich zurückzuführen, da Echtzeit-Renderer nur mit drei Komponenten (RGB) für den gesamten Bereich des sichtbaren Lichts arbeiten. In dieser Arbeit zeigen wir, wie man ein Dünnschichtmodell entzerrt, wie man es in die Mikrofacettentheorie einbezieht und wie man es in eine Echtzeit-Rendering-Engine integriert. Dies erweitert den Bereich der reproduzierbaren Erscheinungen mit Mikrofacettenmodellen.

Lineare Lichtabschattung mit linear transformierten Kosinuskurven

Eric Heitz, Stephen Hill (Lucasfilm) - GPU Zen (Buch)

In diesem Buchkapitel erweitern wir unser Flächenlicht-Framework, das auf linear transformierten Kosinuslinien basiert, um lineare (oder Linien-) Lichter zu unterstützen. Lineare Lichter sind eine gute Annäherung an zylindrische Lichter mit einem kleinen Radius, der nicht gleich Null ist. Wir beschreiben, wie diese Lichter durch lineare Lichter mit ähnlicher Leistung und Schattierung angenähert werden können, und diskutieren die Gültigkeit dieser Annäherung.

Eine praktische Einführung in die Frequenzanalyse des Lichtteilchentransports

Laurent Belcour - ACM SIGGRAPH Kurse 2016

Die Frequenzanalyse des Lichttransports bringt das physikalisch basierte Rendering (PBR) mit Hilfe von Signalverarbeitungswerkzeugen zum Ausdruck. Es ist also darauf zugeschnitten, die Abtastrate vorherzusagen, eine Rauschunterdrückung durchzuführen, Anti-Aliasing zu betreiben, usw. Es wurden viele Methoden vorgeschlagen, um spezielle Fälle des Lichttransports zu behandeln (Bewegung, Linsen usw.). Dieser Kurs zielt darauf ab, Konzepte einzuführen und praktische Anwendungsszenarien der Frequenzanalyse des Lichttransports in einem einheitlichen Kontext zu präsentieren. Um das Verständnis der theoretischen Elemente zu erleichtern, wird die Frequenzanalyse zusammen mit einer Implementierung eingeführt.

2016

Polygonale Licht-Schatten-Effekte in Echtzeit mit linear transformiertem Cosinus

Eric Heitz, Jonathan Dupuy, Stephen Hill (Ubisoft), David Neubelt (Ready at Dawn Studios) - ACM SIGGRAPH 2016

Die Schattierung mit Flächenlichtern verleiht CG-Renderings ein hohes Maß an Realismus. Allerdings müssen dabei sphärische Gleichungen gelöst werden, was für das Rendering in Echtzeit eine Herausforderung darstellt. In diesem Projekt entwickeln wir eine neue sphärische Verteilung, die es uns ermöglicht, physikalisch basierte Materialien mit polygonalen Lichtern in Echtzeit zu schattieren.