Publications sur l'unité

2022

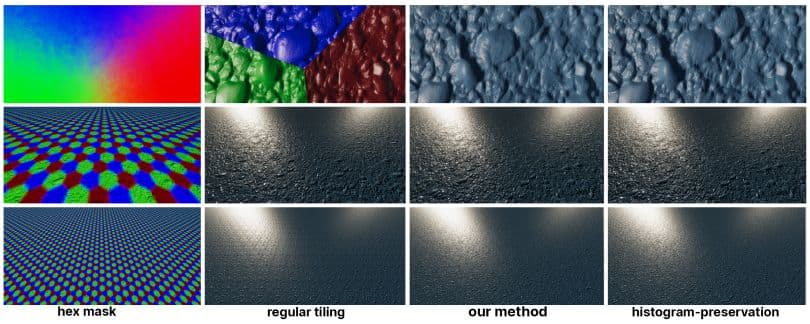

Hex-Tiling pratique en temps réel

Morten S. Mikkelsen - Journal of Computer Graphics Techniques (JCGT)

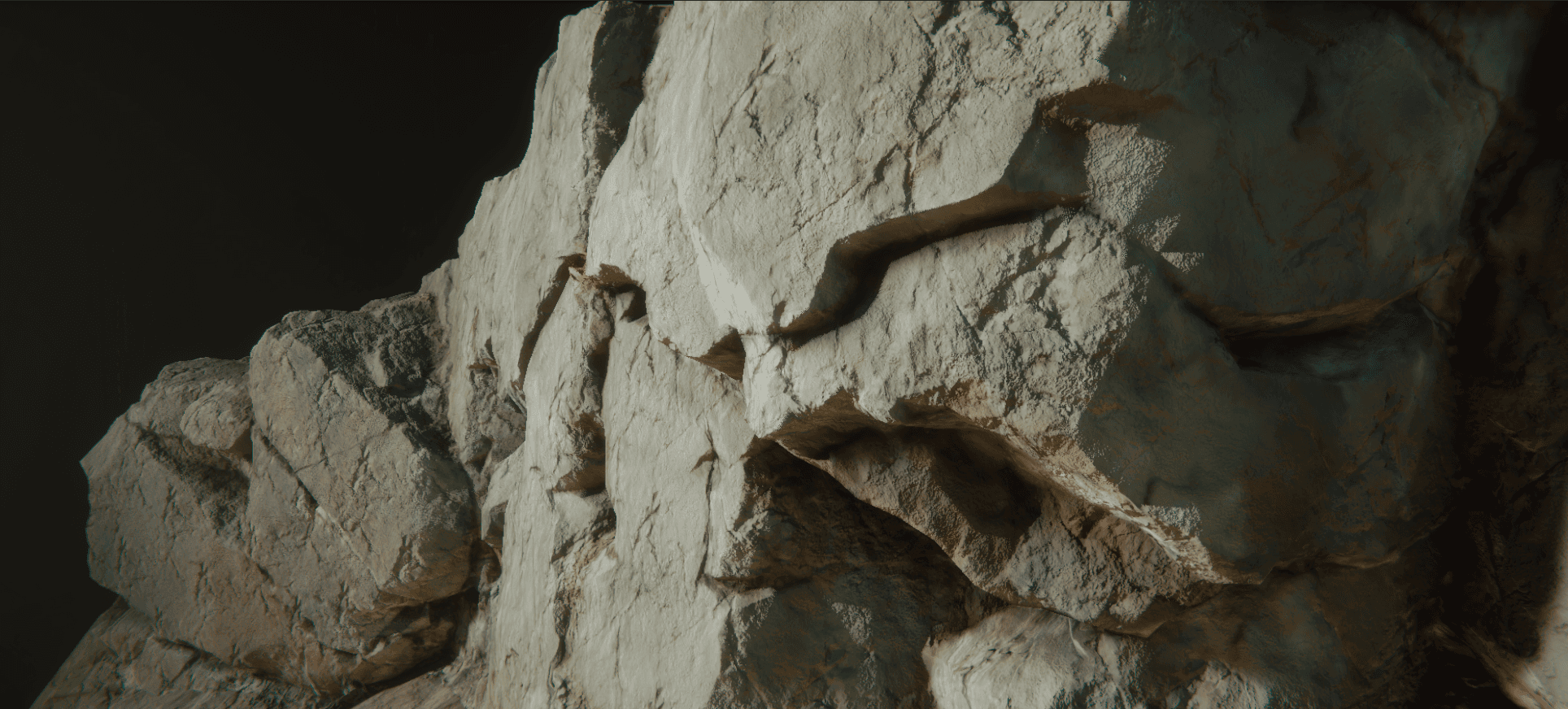

Afin de fournir une approche pratique et facile à adopter pour les textures aléatoires dans le contexte des graphiques en temps réel, nous proposons une adaptation de l'algorithme de bruit par exemple de Heitz et Neyret. La méthode originale préserve le contraste à l'aide d'une méthode de préservation de l'histogramme qui nécessite une étape de précalcul pour convertir la texture source en une texture de transformation et de transformation inverse, qui doivent toutes deux être échantillonnées dans le nuanceur plutôt que dans la texture source originale. Il faut donc une intégration profonde dans l'application pour que cela paraisse opaque à l'auteur du nuanceur et du matériau. Dans notre adaptation, nous omettons la préservation de l'histogramme et la remplaçons par une nouvelle méthode de mélange qui nous permet d'échantillonner la texture source originale. Cette omission est particulièrement judicieuse pour une carte de normalité, puisqu'elle représente les dérivées partielles d'une carte de hauteur. Afin d'atténuer la transition entre les tuiles hexagonales, nous introduisons une métrique simple pour ajuster les poids de mélange. Pour une texture de couleur, nous réduisons la perte de contraste en appliquant une fonction de contraste directement aux poids de mélange. Bien que notre méthode fonctionne pour la couleur, nous mettons l'accent sur l'utilisation des cartes normales dans notre travail car le bruit non répétitif est idéal pour imiter les détails de la surface en perturbant les normales.

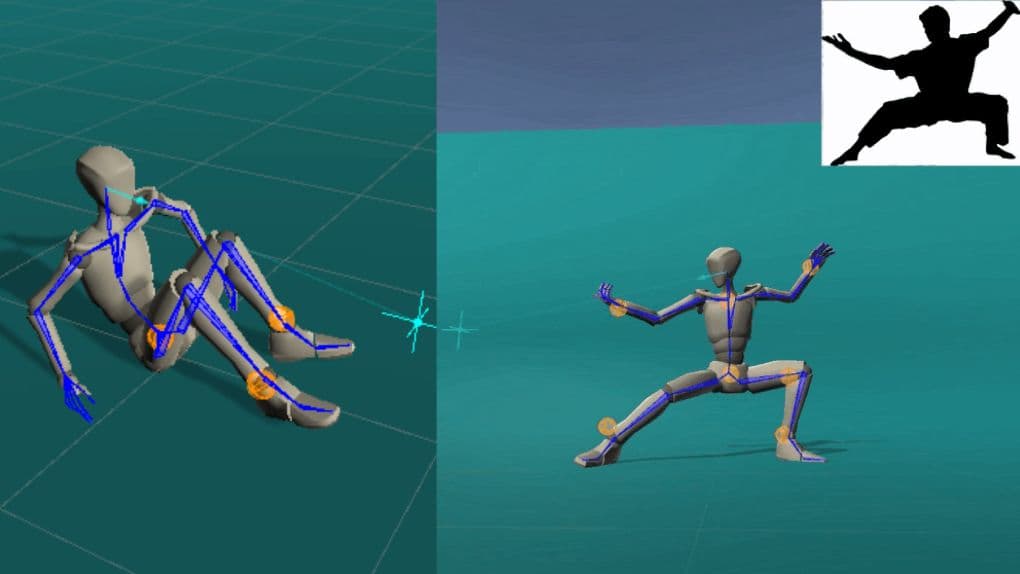

ProtoRes : Architecture proto-résiduelle pour la modélisation en profondeur de la pose humaine

Boris N. Oreshkin, Florent Bocquelet, Félix G. Harvey, Bay Raitt, Dominic Laflamme - ICLR 2022 (Oral, top 5% des papiers acceptés)

Nos travaux portent sur le développement d'une représentation neuronale de la pose humaine pouvant être apprise et destinée à des outils d'animation avancés assistés par l'IA. Plus précisément, nous nous attaquons au problème de la construction d'une pose humaine statique complète sur la base d'informations rares et variables fournies par l'utilisateur (par exemple, l'emplacement et/ou l'orientation d'un sous-ensemble d'articulations du corps). Pour résoudre ce problème, nous proposons une nouvelle architecture neuronale qui combine des connexions résiduelles avec un encodage prototype d'une pose partiellement spécifiée pour créer une nouvelle pose complète à partir de l'espace latent appris. Nous montrons que notre architecture est plus performante qu'une architecture de référence basée sur Transformer, à la fois en termes de précision et d'efficacité de calcul. En outre, nous développons une interface utilisateur pour intégrer notre modèle neuronal dans Unity, une plateforme de développement 3D en temps réel. En outre, nous présentons deux nouveaux ensembles de données représentant le problème de la modélisation de la pose humaine statique, basés sur des données de capture de mouvements humains de haute qualité, qui seront rendus publics avec le code du modèle.

Htex : Texturation par demi-bord pour des topologies de maillage arbitraires

Wilhem Barbier, Jonathan Dupuy - HPG 2022

Nous présentons la texturation par demi-bord (Htex), une méthode adaptée au GPU pour texturer des polygones-mailles arbitraires sans paramétrage explicite. Htex repose sur l'idée que les demi-arêtes encodent une triangulation intrinsèque pour les maillages polygonaux, où chaque demi-arête couvre un triangle unique avec des informations d'adjacence directes. Plutôt que de stocker une texture distincte par face du maillage d'entrée, comme le font les méthodes de texturation sans paramétrage précédentes, Htex stocke une texture carrée pour chaque demi-arête et sa jumelle. Nous montrons que ce simple changement de face à demi-bord induit deux propriétés importantes pour une texturation sans paramétrage de haute performance. Tout d'abord, Htex prend en charge nativement les polygones arbitraires sans nécessiter de code spécifique pour, par exemple, les faces non quadrangulaires. Deuxièmement, Htex conduit à une implémentation GPU simple et efficace qui n'utilise que trois textures par demi-arête pour produire une texture continue sur l'ensemble du maillage. Nous démontrons l'efficacité de Htex par le rendu en temps réel d'actifs de production.

Paradigme axé sur les données pour transfert de radiance précomputé

Laurent Belcour, Thomas Deliot, Wilhem Barbier, Cyril Soler - HPG 2022

Dans ce travail, nous explorons un changement de paradigme pour construire des méthodes de transfert de radiance précalculée (PRT) d'une manière axée sur les données. Ce changement de paradigme nous permet d'atténuer les difficultés liées à l'élaboration des méthodes traditionnelles d'outillage, telles que la définition d'une base de reconstruction, le codage d'un traceur de chemin dédié au calcul d'une fonction de transfert, etc. Notre objectif est d'ouvrir la voie aux méthodes d'apprentissage automatique en fournissant un algorithme de base simple. Plus précisément, nous démontrons le rendu en temps réel de l'éclairage indirect dans les cheveux et les surfaces à partir de quelques mesures de l'éclairage direct. Nous construisons notre base de référence à partir de paires de rendus d'éclairage direct et indirect en utilisant uniquement des outils standard tels que la décomposition en valeurs singulières (SVD) pour extraire à la fois la base de reconstruction et la fonction de transfert.

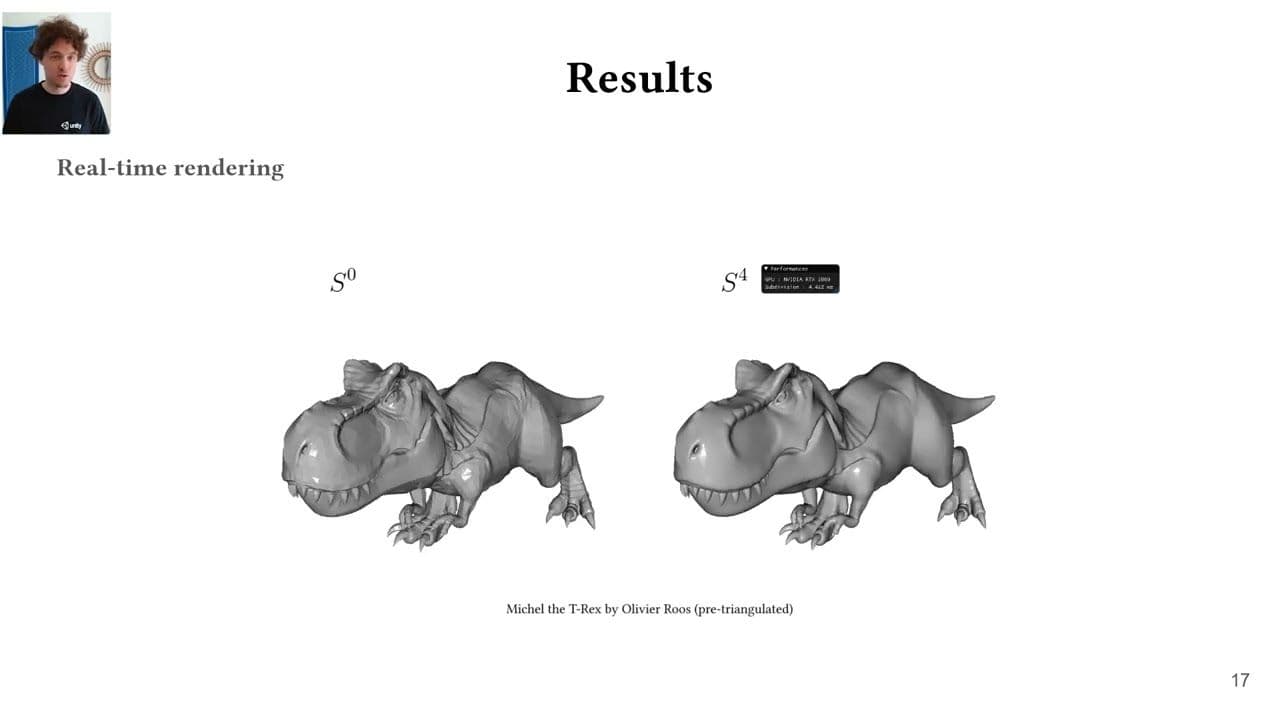

Règle de raffinement de demi-arête pour subdivision de boucle Parallel

Laurent Belcour, Thomas Deliot, Wilhem Barbier, Cyril Soler - HPG 2022

Dans ce travail, nous explorons un changement de paradigme pour construire des méthodes de transfert de radiance précalculée (PRT) d'une manière axée sur les données. Ce changement de paradigme nous permet d'atténuer les difficultés liées à l'élaboration des méthodes traditionnelles d'outillage, telles que la définition d'une base de reconstruction, le codage d'un traceur de chemin dédié au calcul d'une fonction de transfert, etc. Notre objectif est d'ouvrir la voie aux méthodes d'apprentissage automatique en fournissant un algorithme de base simple. Plus précisément, nous démontrons le rendu en temps réel de l'éclairage indirect dans les cheveux et les surfaces à partir de quelques mesures de l'éclairage direct. Nous construisons notre base de référence à partir de paires de rendus d'éclairage direct et indirect en utilisant uniquement des outils standard tels que la décomposition en valeurs singulières (SVD) pour extraire à la fois la base de reconstruction et la fonction de transfert.

Faire passer les cosinus transformés linéairement au GGX anisotropique

Aakash KT, Eric Heitz, Jonathan Dupuy, P.J. Narayanan - I3D 2022

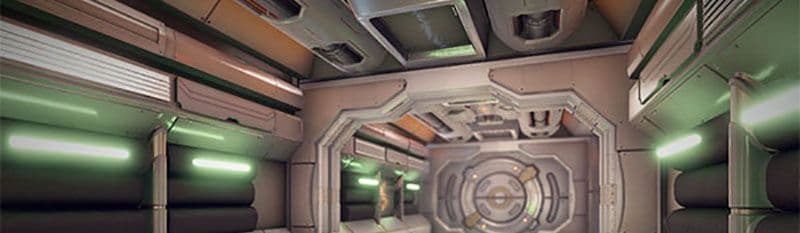

Les cosinus transformés linéairement (LTC) sont une famille de distributions utilisées pour l'ombrage de la lumière en temps réel grâce à leurs propriétés d'intégration analytique. Les moteurs de jeu modernes utilisent une approximation LTC du modèle GGX omniprésent, mais cette approximation n'existe actuellement que pour le GGX isotrope et le GGX anisotrope n'est donc pas pris en charge. Alors que la dimensionnalité plus élevée représente un défi en soi, nous montrons que plusieurs problèmes supplémentaires se posent lors de l'ajustement, du post-traitement, du stockage et de l'interpolation des LTC dans le cas anisotrope. Chacune de ces opérations doit être effectuée avec soin pour éviter les artefacts de rendu. Nous trouvons des solutions robustes pour chaque opération en introduisant et en exploitant les propriétés d'invariance des LTC. Nous obtenons ainsi une petite table de recherche de 8^4 qui fournit une approximation LTC plausible et sans artefact du GGX anisotrope et l'applique à l'ombrage en temps réel des zones lumineuses.

Rendu de matériaux stratifiés avec des interfaces diffuses

Héloïse de Dinechin, Laurent Belcour - I3D 2022

Dans ce travail, nous introduisons une nouvelle méthode pour rendre, en temps réel, des surfaces lambertiennes avec un revêtement diélectrique rugueux. Nous montrons que l'apparence de ces configurations est fidèlement représentée par deux lobes de microfacettes représentant respectivement les interactions directes et indirectes. Nous ajustons numériquement ces lobes sur la base des statistiques directionnelles de premier ordre (énergie, moyenne et variance) du transport de la lumière à l'aide de tables 5D et nous les réduisons à 2D + 1D à l'aide de formes analytiques et d'une réduction des dimensions. Nous démontrons la qualité de notre méthode en rendant efficacement des plastiques et des céramiques rugueux, correspondant étroitement à la réalité du terrain. En outre, nous améliorons un modèle de matériau en couches de pointe pour inclure les interfaces lambertiennes.

- 2021-2019 USD

FC-GAGA : Architecture de graphe à portes entièrement connectées pour les prévisions de trafic spatio-temporelles

Boris N. Oreshkin, Arezou Amini, Lucy Coyle, Mark J. Coates (AAAI 2021)

La prévision de séries temporelles multivariées est un problème important qui trouve des applications dans la gestion du trafic, la configuration des réseaux cellulaires et la finance quantitative. Un cas particulier du problème se présente lorsqu'il existe un graphique qui capture les relations entre les séries temporelles. Dans cet article, nous proposons une nouvelle architecture d'apprentissage qui permet d'obtenir des performances comparables ou supérieures aux meilleurs algorithmes existants, sans avoir besoin de connaître le graphe. L'élément clé de l'architecture que nous proposons est le mécanisme d'apprentissage du graphe dur entièrement connecté qui permet d'utiliser l'architecture de prévision de séries temporelles entièrement connectées la plus moderne et la plus efficace sur le plan du calcul dans les applications de prévision du trafic. Les résultats expérimentaux pour deux ensembles de données de réseaux de trafic public illustrent la valeur de notre approche, et les études d'ablation confirment l'importance de chaque élément de l'architecture.

Perte de Wasserstein en tranches pour la synthèse de textures neuronales

Eric Heitz,Kenneth Vanhoey,Thomas Chambon,Laurent Belcour. À paraître dans le CVPR 2021

Nous abordons le problème du calcul d'une perte texturale basée sur les statistiques extraites des activations de caractéristiques d'un réseau neuronal convolutionnel optimisé pour la reconnaissance d'objets (par exemple VGG-19). Le problème mathématique sous-jacent est la mesure de la distance entre deux distributions dans l'espace des caractéristiques. La perte de la matrice de Gram est l'approximation la plus répandue pour ce problème, mais elle présente plusieurs inconvénients. Notre objectif est de promouvoir la distance de Wasserstein en tranches et de la remplacer. Elle est théoriquement prouvée, pratique, simple à mettre en œuvre et permet d'obtenir des résultats visuellement supérieurs pour la synthèse de textures par optimisation ou l'entraînement de réseaux neuronaux génératifs.

Amélioration du niveau de détail des shaders et des textures grâce aux cônes de rayonnement

Tomas Akenine-Möller, Cyril Crassin, Jakub Boksansky, Laurent Belcour, Alexey Panteleev, Oli Wright.Publié dans le Journal of Computer Graphics Techniques (JCGT)

Dans le domaine du ray tracing en temps réel, le filtrage des textures est une technique importante pour améliorer la qualité de l'image. Les jeux actuels, tels que Minecraft avec RTX sur Windows 10, utilisent des cônes de rayons pour déterminer les empreintes de filtrage de texture. Dans cet article, nous présentons plusieurs améliorations de l'algorithme des cônes-rayons qui améliorent la qualité de l'image et les performances et facilitent son adoption dans les moteurs de jeu. Nous montrons que le temps total par image peut diminuer d'environ 10 % dans un traceur de chemin basé sur le GPU, et nous fournissons une mise en œuvre dans le domaine public.

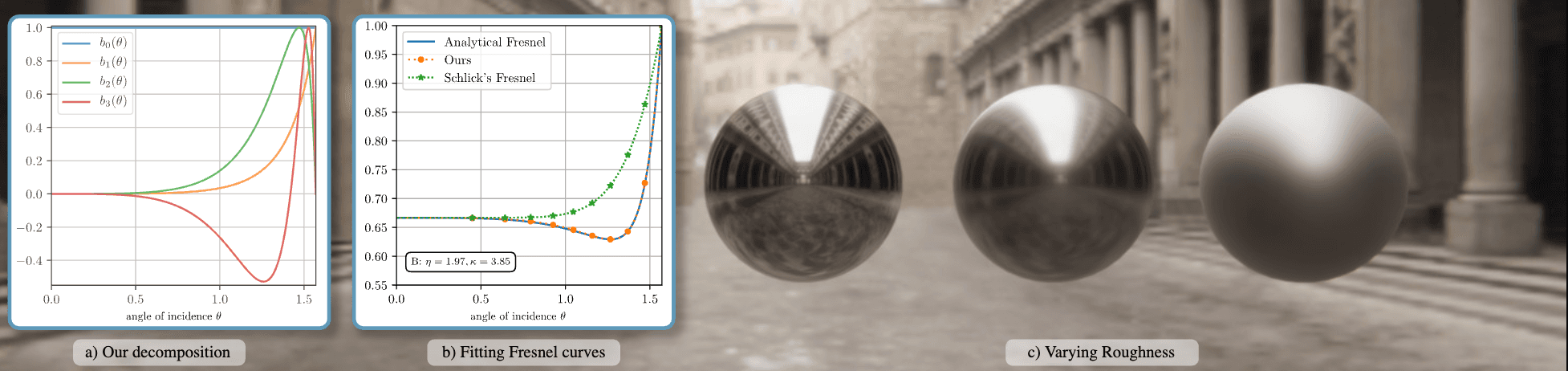

Une décomposition pré-intégrable pour obtenir un Fresnel précis pour le rendu en temps réel

Laurent Belcour,Megane Bati,Pascal Barla.Publié dans le ACM SIGGRAPH 2020 Talks and Courses

Nous introduisons un nouveau modèle approximatif de réflectance de Fresnel qui permet la reproduction précise de la réflectance réelle dans les moteurs de rendu en temps réel. Notre méthode est basée sur une décomposition empirique de l'espace des courbes de Fresnel possibles. Il est compatible avec la pré-intégration des éclairages à base d'images et des éclairages de zone utilisés dans les moteurs en temps réel. Notre travail permet d'utiliser une paramétrisation de la réflectance [Gulbrandsen 2014] qui était auparavant limitée au rendu hors ligne.

Arbres binaires simultanés

Jonathan Dupuy - HPG 2020

Nous présentons l'arbre binaire concurrent (CBT), une nouvelle représentation concurrente permettant de construire et de mettre à jour des arbres binaires arbitraires en parallèle. Fondamentalement, notre représentation consiste en un tas binaire, c'est-à-dire un tableau 1D, qui stocke explicitement l'arbre de réduction de la somme d'un champ de bits. Dans ce champ de bits, chaque bit à valeur unique représente un nœud de feuille de l'arbre binaire codé par le CBT, que nous localisons algorithmiquement à l'aide d'une recherche binaire sur la réduction de la somme. Nous montrons que cette construction permet de distribuer jusqu'à un thread par nœud feuille et que, à leur tour, ces threads peuvent en toute sécurité diviser et/ou supprimer des nœuds simultanément par le biais de simples opérations bit à bit sur le champ de bits. L'avantage pratique des CBT réside dans leur capacité à accélérer les algorithmes basés sur les arbres binaires avec des processeurs parallèles. Pour étayer cette affirmation, nous nous appuyons sur notre représentation pour accélérer un algorithme basé sur la bissection du bord le plus long qui calcule et rend une géométrie adaptative pour des terrains à grande échelle entièrement sur le GPU. Pour cet algorithme spécifique, le CBT accélère la vitesse de traitement de manière linéaire avec le nombre de processeurs.

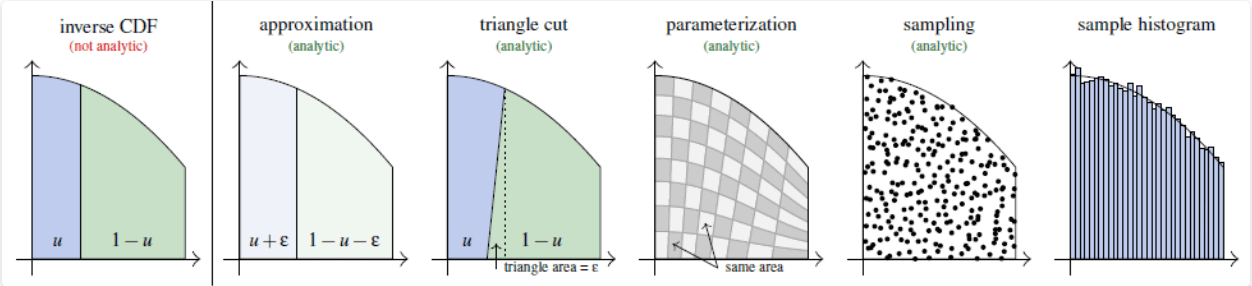

Impossible d'inverser le CDF ? Paramétrage de la région sous la courbe par la coupe du triangle

Eric Heitz - EGSR 2020

Nous présentons une méthode exacte, analytique et déterministe pour l'échantillonnage des densités dont les fonctions de distribution cumulative (FDC) ne peuvent pas être inversées analytiquement. En effet, la méthode inverse de la FCD est souvent considérée comme la meilleure façon d'échantillonner des densités non uniformes. Si la FCD n'est pas analytiquement inversible, les solutions de repli habituelles sont soit approximatives, soit numériques, soit non déterministes, comme l'acceptation-rejet. Pour surmonter ce problème, nous montrons comment calculer un paramétrage analytique préservant la surface de la région sous la courbe de la densité cible. Nous l'utilisons pour générer des points aléatoires uniformément distribués sous la courbe de la densité cible et leurs abscisses sont donc distribuées avec la densité cible. Techniquement, notre idée est d'utiliser une paramétrisation analytique approximative dont l'erreur peut être représentée géométriquement sous la forme d'un triangle simple à découper. Cette paramétrisation en triangle permet d'obtenir des solutions exactes et analytiques à des problèmes d'échantillonnage qui n'étaient vraisemblablement pas résolubles analytiquement.

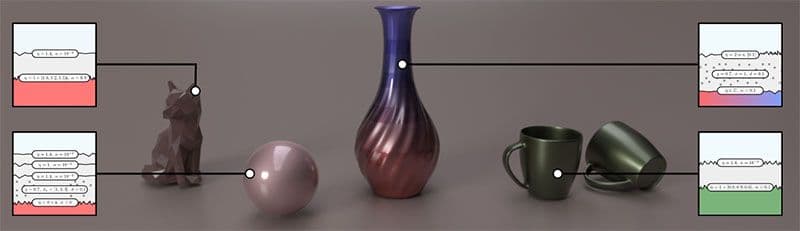

Rendu de matériaux stratifiés avec des interfaces anisotropes

Philippe Weier,Laurent Belcour.Publié dans Journal of Computer Graphics Techniques (JCGT)

Nous présentons une méthode légère et efficace pour rendre des matériaux en couches avec des interfaces anisotropes. Notre travail étend notre cadre statistique publié précédemment pour traiter les modèles de microfacettes anisotropes. Une idée clé de notre travail est que, lorsqu'ils sont projetés sur le plan tangent, les lobes de la FDRB d'une distribution GGX anisotrope sont bien approximés par des distributions ellipsoïdales alignées sur le cadre tangent : sa matrice de covariance est diagonale dans cet espace. Nous tirons parti de cette propriété et exécutons l'algorithme isotrope en couches sur chaque axe d'anisotropie de manière indépendante. Nous avons également mis à jour le mappage de la rugosité à la variance directionnelle et l'évaluation de la réflectance moyenne pour tenir compte de l'anisotropie.

Intégration et simulation de distributions projectives-cauchy bivariées dans des domaines polygonaux arbitraires

Jonathan Dupuy, Laurent Belcour,et Eric Heitz. Rapport technique 2019

Considérons une variable uniforme sur la demi-sphère supérieure unitaire de dimension d. On sait que la projection en ligne droite du centre de la sphère unitaire sur le plan qui la surplombe distribue cette variable selon une distribution projective de Cauchy à d dimensions. Dans ce travail, nous tirons parti de la géométrie de cette construction en dimension d=2 pour dériver de nouvelles propriétés pour la distribution projective-Cauchy bivariée. Plus précisément, nous révélons, par le biais d'intuitions géométriques, que l'intégration et la simulation d'une distribution projective-Cauchy bivariée dans un domaine arbitraire se traduisent respectivement par la mesure et l'échantillonnage de l'angle solide sous-tendu par la géométrie de ce domaine vu depuis l'origine de la sphère unitaire. Afin de rendre ce résultat pratique pour, par exemple, générer des variantes tronquées de la distribution projective-Cauchy bivariée, nous l'étendons à deux égards. Tout d'abord, nous proposons une généralisation aux distributions de Cauchy paramétrées par des coefficients de corrélation à l'échelle du lieu. Deuxièmement, nous proposons une spécialisation pour les domaines polygonaux, ce qui permet d'obtenir des formules fermées. Nous fournissons une implémentation MATLAB complète pour le cas des domaines triangulaires, et discutons brièvement du cas des domaines elliptiques et de la manière d'étendre nos résultats aux distributions de Student bivariées.

Cadre de cartographie des bosses basé sur le gradient de surface

Morten Mikkelsen 2020

Dans ce document, un nouveau framework vous est proposé pour la superposition/composition de bump/normal maps, incluant la prise en charge de multiples ensembles de coordonnées de texture ainsi que de coordonnées de texture et de géométrie générées par des procédures. En outre, nous fournissons une prise en charge et une intégration appropriées pour les bump maps définies sur un volume, comme les projecteurs de décalcomanies, la projection triplanaire et les fonctions basées sur le bruit.

Multi-stylisation des jeux vidéo en temps réel guidée par les informations du G-buffer

Adèle Saint-Denis, Kenneth Vanhoey, Thomas Deliot HPG 2019

Nous étudions comment tirer parti des techniques modernes de transfert de style neuronal pour modifier le style des jeux vidéo au moment de l'exécution. Les réseaux neuronaux de transfert de style récents sont pré-entraînés et permettent un transfert rapide de n'importe quel style au moment de l'exécution. Cependant, un style unique s'applique globalement, sur l'ensemble de l'image, alors que nous voudrions fournir à l'utilisateur des outils de création plus fins. Dans ce travail, nous permettons à l'utilisateur d'attribuer des styles (au moyen d'une image de style) à diverses quantités physiques trouvées dans le tampon G d'un pipeline de rendu différé, comme la profondeur, les normales ou l'ID de l'objet. Notre algorithme interpole ensuite ces styles en fonction de la scène à rendre : par exemple, un style différent apparaît pour différents objets, profondeurs ou orientations.

- 2019-2018 USD

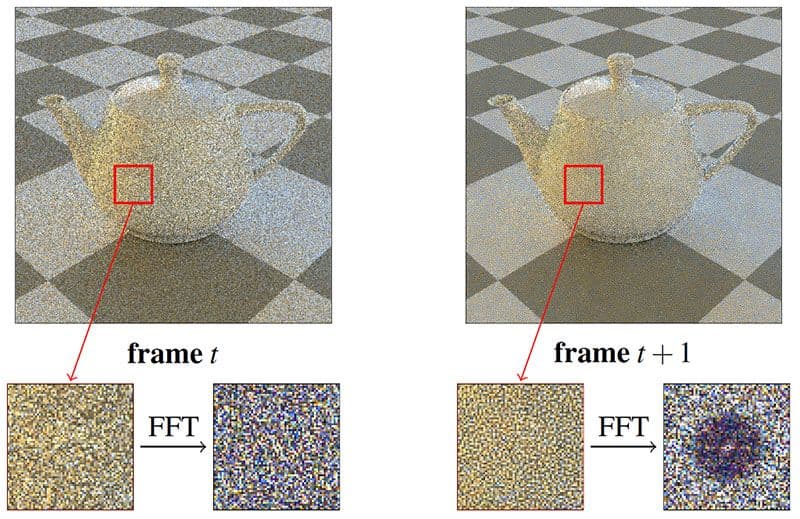

Distribution des erreurs de Monte Carlo sous forme de bruit bleu dans l'espace de l'écran par la permutation des graines de pixels entre les images

Eric Heitz, Laurent Belcour - EGSR2019

Nous présentons un échantillonneur qui génère des échantillons par pixel de haute qualité visuelle grâce à deux propriétés clés liées aux erreurs de Monte Carlo qu'il produit. Tout d'abord, la séquence de chaque pixel est une séquence de Sobol embrouillée à la Owen qui présente des propriétés de convergence de pointe. Les erreurs de Monte Carlo sont donc de faible ampleur. Deuxièmement, ces erreurs sont distribuées sous la forme d'un bruit bleu dans l'espace de l'écran. Cela les rend visuellement encore plus acceptables. Notre échantillonneur est léger et rapide. Nous l'implémentons avec une petite texture et deux opérations xor. Notre matériel complémentaire fournit des comparaisons avec des travaux antérieurs pour différentes scènes et différents nombres d'échantillons.

Un échantillonneur à faible discrépance qui distribue les erreurs de Monte Carlo sous forme de bruit bleu dans l'espace de l'écran

Eric Heitz, Laurent Belcour - ACM SIGGRAPH Talk 2019

Nous présentons un échantillonneur qui génère des échantillons par pixel de haute qualité visuelle grâce à deux propriétés clés liées aux erreurs de Monte Carlo qu'il produit. Tout d'abord, la séquence de chaque pixel est une séquence de Sobol embrouillée à la Owen qui présente des propriétés de convergence de pointe. Les erreurs de Monte Carlo sont donc de faible ampleur. Deuxièmement, ces erreurs sont distribuées sous la forme d'un bruit bleu dans l'espace de l'écran. Cela les rend visuellement encore plus acceptables. Notre échantillonneur est léger et rapide. Nous l'implémentons avec une petite texture et deux opérations xor. Notre matériel complémentaire fournit des comparaisons avec des travaux antérieurs pour différentes scènes et différents nombres d'échantillons.

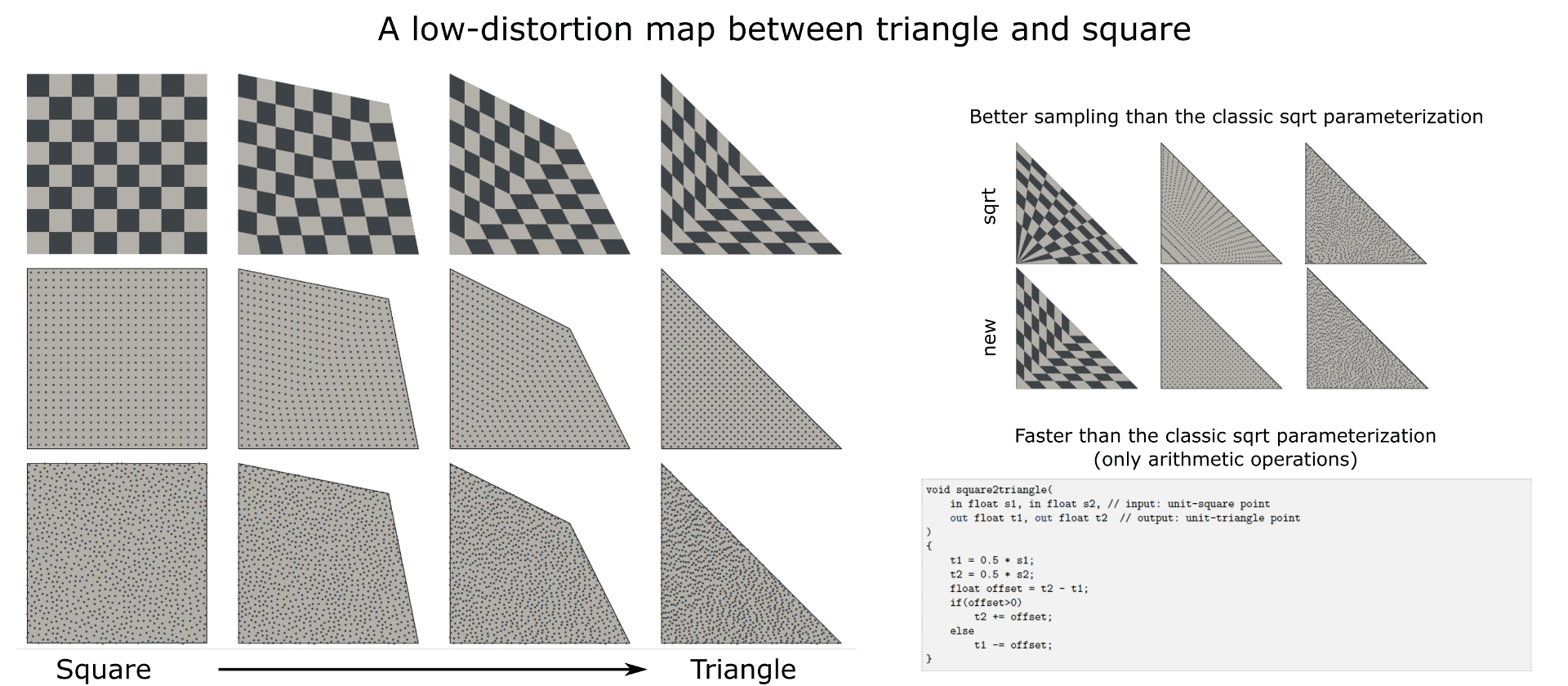

Une carte à faible distorsion entre le triangle et le carré

Eric Heitz - Rapport technique 2019

Nous introduisons une carte à faible distorsion entre le triangle et le carré. Cette correspondance permet d'obtenir un paramétrage préservant la surface qui peut être utilisé pour échantillonner des points aléatoires avec une densité uniforme dans des triangles arbitraires. Ce paramétrage présente deux avantages par rapport au paramétrage de la racine carrée généralement utilisé pour l'échantillonnage triangulaire. Tout d'abord, elle présente des distorsions plus faibles et préserve mieux les propriétés de bruit bleu des échantillons d'entrée. Deuxièmement, son calcul repose uniquement sur des opérations arithmétiques (+, *), ce qui rend son évaluation plus rapide.

Échantillonnage de la distribution GGX des normales visibles

Eric Heitz - JCGT 2018

L'échantillonnage d'importance des BSDF de microfacettes à l'aide de leur distribution des normales visibles (VNDF) permet une réduction significative de la variance dans le rendu Monte Carlo. Dans cet article, nous décrivons une routine d'échantillonnage efficace et exacte pour la VNDF de la distribution de microfacettes GGX. Cette routine tire parti du fait que GGX est la distribution des normales d'un ellipsoïde tronqué et que l'échantillonnage du GGX VNDF équivaut à l'échantillonnage de la projection 2D de cet ellipsoïde tronqué. Pour ce faire, nous simplifions le problème en utilisant la transformation linéaire qui transforme l'ellipsoïde tronqué en hémisphère. Étant donné que les transformations linéaires préservent l'uniformité des zones projetées, l'échantillonnage dans la configuration de l'hémisphère et la retransformation des échantillons dans la configuration de l'ellipsoïde permettent d'obtenir des échantillons valides du GGX VNDF.

Calcul analytique de l'angle solide sous-tendu par un ellipsoïde arbitrairement positionné par rapport à une source ponctuelle

Eric Heitz - Instruments et méthodes nucléaires dans la recherche en physique 2018

Nous présentons une méthode géométrique pour calculer une ellipse qui sous-tend le même domaine d'angle solide qu'un ellipsoïde positionné arbitrairement. Cette méthode permet d'étendre les calculs analytiques existants de l'angle solide des ellipses aux ellipsoïdes. Notre idée consiste à appliquer une transformation linéaire à l'ellipsoïde de manière à le transformer en une sphère à partir de laquelle un disque couvrant le même domaine d'angle solide peut être calculé. Nous démontrons qu'en appliquant la transformation linéaire inverse sur ce disque, nous obtenons une ellipse qui sous-tend le même domaine d'angle solide que l'ellipsoïde. Nous fournissons une implémentation MATLAB de notre algorithme et nous le validons numériquement.

Note sur l'échantillonnage de la longueur des voies avec des distributions non exponentielles

Eric Heitz, Laurent Belcour - Tech Report 2018

L'échantillonnage par longueur de voie consiste à échantillonner des intervalles aléatoires en fonction d'une distribution de distance. Cela signifie qu'au lieu d'échantillonner une distance ponctuelle à partir de la distribution des distances, l'échantillonnage des longueurs de piste génère un intervalle de distances possibles. Le processus d'échantillonnage des longueurs de piste est correct si l'espérance des intervalles est la distribution des distances cible. En d'autres termes, la moyenne de tous les intervalles échantillonnés devrait converger vers la distribution des distances au fur et à mesure que leur nombre augmente. Dans cette note, nous insistons sur le fait que la distribution des distances utilisée pour l'échantillonnage des distances ponctuelles et la distribution des longueurs de voies utilisée pour l'échantillonnage des intervalles ne sont généralement pas les mêmes. Cette différence peut être surprenante car, à notre connaissance, l'échantillonnage des longueurs de voies a été principalement étudié dans le contexte de la théorie des transports où la distribution des distances est typiquement exponentielle : dans ce cas particulier, la distribution des distances et la distribution des longueurs de voies se trouvent être toutes deux la même distribution exponentielle. Toutefois, elles ne sont généralement pas identiques lorsque la distribution des distances est non exponentielle.

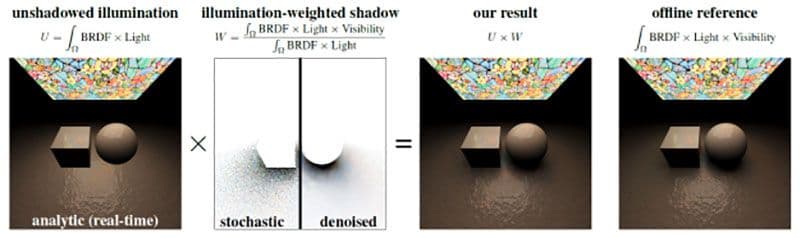

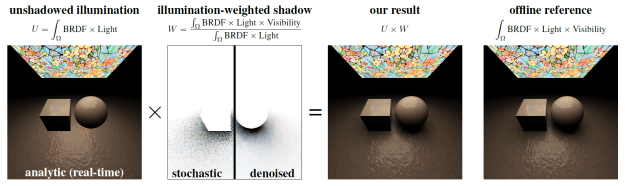

Combinaison de l'éclairage direct analytique et des ombres stochastiques

Eric Heitz, Stephen Hill (Lucasfilm), Morgan McGuire (NVIDIA) - I3D 2018 (article court) (Prix de la meilleure présentation)

Dans cet article, nous proposons un estimateur de ratio de l'équation d'illumination directe qui nous permet de combiner des techniques d'illumination analytiques avec des ombres stochastiques tracées dans les rayons tout en maintenant la correction. Notre principale contribution est de montrer que l'éclairage ombragé peut être divisé en un produit de l'éclairage non ombragé et de l'ombre pondérée par l'éclairage. Ces termes peuvent être calculés séparément - éventuellement en utilisant des techniques différentes - sans affecter l'exactitude du résultat final donné par leur produit. Cette formulation élargit l'utilité des techniques d'éclairage analytique aux applications de raytracing, où elles étaient jusqu'à présent évitées parce qu'elles n'intégraient pas les ombres. Nous utilisons ces méthodes pour obtenir un ombrage net et sans bruit dans l'image d'illumination sans ombre et nous calculons l'image d'ombre pondérée à l'aide d'un traçage stochastique des rayons. L'avantage de limiter l'évaluation stochastique à l'image des ombres pondérées est que le résultat final ne présente du bruit que dans les ombres. En outre, nous débruitons les ombres séparément de l'éclairage, de sorte que même un débruitage agressif ne brouille que les ombres, tandis que les détails d'ombrage à haute fréquence (textures, cartes normales, etc.) sont préservés.

Tuiles non périodiques des fonctions de bruit de procédure

Aleksandr Kirillov - HPG 2018

Les fonctions de bruit procédural ont de nombreuses applications en infographie, allant de la synthèse de textures à la simulation d'effets atmosphériques ou à la spécification de la géométrie des paysages. Le bruit peut être soit précalculé et stocké dans une texture, soit évalué directement lors de l'exécution de l'application. Ce choix offre un compromis entre la variance de l'image, la consommation de mémoire et les performances.

Des algorithmes de pavage avancés peuvent être utilisés pour réduire la répétition visuelle. Les tuiles Wang permettent de recouvrir un plan d'une manière non périodique, en utilisant un ensemble relativement restreint de textures. Les tuiles peuvent être disposées dans une carte de texture unique pour permettre au GPU d'utiliser le filtrage matériel.

Dans cet article, nous présentons des modifications de plusieurs fonctions de bruit procédurales populaires qui produisent directement des cartes de texture contenant le plus petit ensemble complet de tuiles de Wang. Les résultats présentés dans cet article permettent de créer des tuiles non périodiques de ces fonctions de bruit et des textures basées sur celles-ci, à la fois en cours d'exécution et en tant qu'étape de prétraitement. Ces résultats permettent également de diminuer la répétition des effets de bruit dans les images générées par ordinateur à un faible coût en termes de performances, tout en maintenant, voire en réduisant, la consommation de mémoire.

Bruit par exemple à haute performance utilisant un opérateur de mélange préservant l'histogramme

Eric Heitz, Fabrice Neyret (Inria) - HPG 2018 (Best Paper Award)

Nous proposons un nouvel algorithme de bruit par exemple qui prend en entrée un petit exemple de texture stochastique et synthétise une sortie infinie avec la même apparence. Il fonctionne sur n'importe quel type d'entrée à phase aléatoire ainsi que sur de nombreuses entrées à phase non aléatoire qui sont stochastiques et non périodiques, typiquement des textures naturelles telles que la mousse, le granit, le sable, l'écorce, etc. Notre algorithme permet d'obtenir des résultats de haute qualité, comparables aux techniques de pointe en matière de bruit procédural, mais il est plus de 20 fois plus rapide.

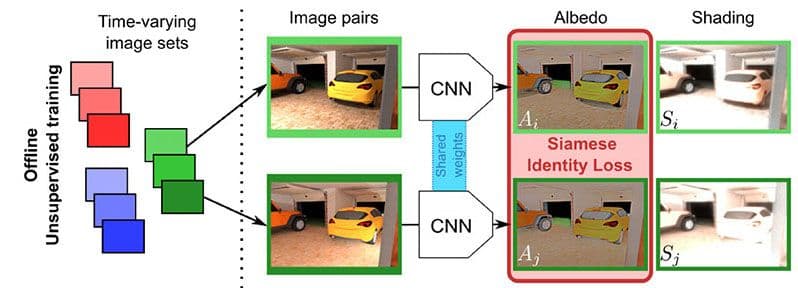

Décomposition intrinsèque profonde non supervisée d'une seule image à l'aide de séquences d'images à variation d'illumination

Louis Lettry (ETH Zürich), Kenneth Vanhoey, Luc Van Gool (ETH Zürich) - Pacific Graphics 2018 / Computer Graphics Forum

La décomposition intrinsèque décompose une scène photographiée en albédo et ombrage. La suppression des ombres permet de "ravir" les images, qui peuvent ensuite être réutilisées dans des scènes virtuellement rallumées. Nous proposons une méthode d'apprentissage non supervisée pour résoudre ce problème.

Les techniques récentes utilisent l'apprentissage supervisé : elles nécessitent un grand nombre de décompositions connues, qui sont difficiles à obtenir. Au lieu de cela, nous nous entraînons sur des images non annotées en utilisant des images à intervalles réguliers obtenues à partir de webcams statiques. Nous exploitons l'hypothèse selon laquelle l'albédo est statique par définition et que l'ombrage varie en fonction de l'éclairage. Nous transcrivons cela en une formation siamoise pour l'apprentissage profond.

2018-2016

Rendu efficace des matériaux stratifiés à l'aide d'une décomposition atomique et d'opérateurs statistiques

Laurent Belcour - ACM SIGGRAPH 2018

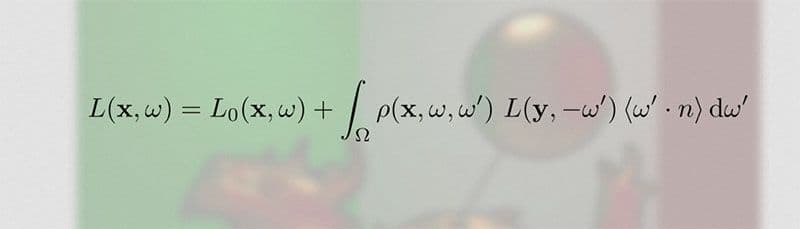

Nous avons élaboré un nouveau cadre pour l'analyse et le calcul efficaces du transport de la lumière dans les matériaux stratifiés. Notre calcul se fait en deux étapes. Tout d'abord, nous décomposons le transport de la lumière en un ensemble d'opérateurs atomiques qui agissent sur ses statistiques directionnelles. En particulier, nos opérateurs consistent en la réflexion, la réfraction, la diffusion et l'absorption, dont les combinaisons sont suffisantes pour décrire les statistiques de la lumière diffusée plusieurs fois à l'intérieur de structures en couches. Nous montrons que les trois premiers moments directionnels (énergie, moyenne et variance) fournissent déjà un résumé précis. Deuxièmement, nous étendons la méthode d'addition-doublement pour prendre en charge efficacement des combinaisons arbitraires de ces opérateurs. Pendant l'ombrage, les moments directionnels sont mis en correspondance avec les lobes BSDF. Nous validons que le BSDF résultant correspond étroitement à la vérité terrain sous une forme légère et efficace. Contrairement aux méthodes précédentes, nous prenons en charge un nombre arbitraire de couches texturées et nous démontrons un rendu pratique et précis des matériaux en couches avec une mise en œuvre en ligne et en temps réel qui ne nécessite pas de précalcul par matériau.

Paramétrage adaptatif pour l'acquisition et le rendu des matériaux

Jonathan Dupuy et Wenzel Jakob (EPFL) - ACM SIGGRAPH Asia 2018

L'un des ingrédients clés de tout système de rendu basé sur la physique est une spécification détaillée caractérisant l'interaction de la lumière et de la matière de tous les matériaux présents dans une scène, généralement par le biais de la fonction de distribution de la réflectance bidirectionnelle (BRDF). Malgré leur utilité, l'accès aux ensembles de données BRDF du monde réel reste limité : en effet, les mesures impliquent le balayage d'un domaine quadridimensionnel à une résolution suffisante, un processus fastidieux et souvent infaisable qui prend beaucoup de temps. Nous proposons une nouvelle paramétrisation qui s'adapte automatiquement au comportement d'un matériau, en déformant le domaine 4D sous-jacent de manière à ce que la majeure partie du volume soit représentée par des régions où la FDRB prend des valeurs non négligeables, tandis que les régions non pertinentes sont fortement comprimées. Cette adaptation ne nécessite qu'une brève mesure 1D ou 2D des propriétés rétroréfléchissantes du matériau. Notre paramétrage est unifié dans le sens où il combine plusieurs étapes qui nécessitaient auparavant des conversions de données intermédiaires : la même cartographie peut être utilisée simultanément pour l'acquisition et le stockage des FDRB, et elle permet une génération efficace d'échantillons de Monte Carlo.

Ombres stochastiques

Eric Heitz, Stephen Hill (Lucasfilm), Morgan McGuire (NVIDIA)

Dans cet article, nous proposons un estimateur de ratio de l'équation d'illumination directe qui nous permet de combiner des techniques d'illumination analytiques avec des ombres stochastiques tracées dans les rayons tout en maintenant la correction. Notre principale contribution est de montrer que l'éclairage ombragé peut être divisé en un produit de l'éclairage non ombragé et de l'ombre pondérée par l'éclairage. Ces termes peuvent être calculés séparément - éventuellement en utilisant des techniques différentes - sans affecter l'exactitude du résultat final donné par leur produit.

Cette formulation élargit l'utilité des techniques d'éclairage analytique aux applications de raytracing, où elles étaient jusqu'à présent évitées parce qu'elles n'intégraient pas les ombres. Nous utilisons ces méthodes pour obtenir un ombrage net et sans bruit dans l'image d'illumination sans ombre et nous calculons l'image d'ombre pondérée à l'aide d'un traçage stochastique des rayons. L'avantage de limiter l'évaluation stochastique à l'image des ombres pondérées est que le résultat final ne présente du bruit que dans les ombres. En outre, nous débruitons les ombres séparément de l'éclairage, de sorte que même un débruitage agressif ne brouille que les ombres, tandis que les détails d'ombrage à haute fréquence (textures, cartes normales, etc.) sont préservés.

Tessellation adaptative du GPU avec les nuanceurs de calcul

Jad Khoury, Jonathan Dupuy et Christophe Riccio - GPU Zen 2

Les rasterizers GPU sont plus efficaces lorsque les primitives s'étendent sur plus de quelques pixels. En dessous de cette limite, le tampon Z commence à s'aliéner et le taux d'ombrage diminue considérablement [Riccio 12] ; cela rend difficile le rendu de scènes géométriquement complexes, car tout polygone modérément éloigné sera projeté à une taille inférieure au pixel. Afin de minimiser ces projections sous-pixel, une solution simple consiste à affiner de manière procédurale les maillages grossiers au fur et à mesure qu'ils se rapprochent de la caméra. Dans ce chapitre, nous nous intéressons à l'élaboration d'une telle technique de raffinement procédural pour les maillages de polygones arbitraires.

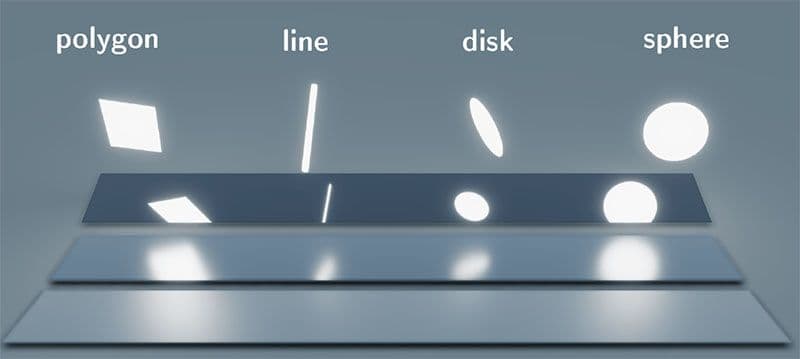

Ombrage en temps réel de la lumière linéaire et de la lumière diffuse avec des cosinus transformés linéairement

Eric Heitz (Unity Technologies) et Stephen Hill (Lucasfilm) - ACM SIGGRAPH Courses 2017

Nous avons récemment introduit une nouvelle technique d'ombrage des lumières en temps réel pour les lumières de forme polygonale. Dans cet exposé, nous étendons ce cadre d'éclairage de zone pour prendre en charge les lumières en forme de lignes, de sphères et de disques en plus des polygones.

- Diapositives

- Code de démonstration

- Démonstration WebGL pour les lumières quadruples, linéaires et à disque

Cartographie normale basée sur les microfacettes pour un traçage robuste de la trajectoire de Monte Carlo

Vincent Schüssler (KIT), Eric Heitz (Unity Technologies), Johannes Hanika (KIT) et Carsten Dachsbacher (KIT) - ACM SIGGRAPH ASIA 2017

La cartographie normale imite les détails visuels des surfaces en utilisant de fausses normales d'ombrage. Cependant, le modèle de surface résultant est géométriquement impossible et la cartographie des normales est donc souvent considérée comme une approche fondamentalement défectueuse qui pose des problèmes inévitables pour le traçage du chemin de Monte Carlo : elle perturbe soit l'apparence (franges noires, perte d'énergie), soit l'intégrateur (transport différent de la lumière vers l'avant et vers l'arrière). Dans cet article, nous présentons la cartographie normale basée sur les microfacettes, une autre façon de truquer les détails géométriques sans corrompre la robustesse du traçage de trajectoire de Monte Carlo, de sorte que ces problèmes ne se posent pas.

Paramétrage préservant la calotte sphérique pour les distributions sphériques

Jonathan Dupuy, Eric Heitz et Laurent Belcour - ACM SIGGRAPH 2017

Nous introduisons un nouveau paramétrage pour les distributions sphériques qui est basé sur un point situé à l'intérieur de la sphère, que nous appelons un pivot. Le pivot sert de centre à une projection en ligne droite qui reporte les angles solides sur la face opposée de la sphère. En transformant les distributions sphériques de cette manière, nous dérivons de nouvelles distributions sphériques paramétriques qui peuvent être évaluées et échantillonnées par importance à partir des distributions originales à l'aide d'expressions simples et fermées. De plus, nous prouvons que si la distribution originale peut être échantillonnée et/ou intégrée sur une calotte sphérique, alors la distribution transformée peut l'être aussi. Nous exploitons les propriétés de notre paramétrage pour dériver des techniques d'éclairage sphérique efficaces pour le rendu en temps réel et hors ligne. Nos techniques sont robustes, rapides, faciles à mettre en œuvre et permettent d'obtenir une qualité supérieure aux travaux antérieurs.

Extension pratique de la théorie de la microfacette pour la modélisation de l'irisation variable

Laurent Belcour (Unity), Pascal Barla (Inria) - ACM SIGGRAPH 2017

L'irisation en couche mince permet de reproduire l'aspect du cuir. Cependant, cette théorie nécessite des moteurs de rendu spectral (tels que Maxwell Render) pour intégrer correctement le changement d'apparence par rapport au point de vue (connu sous le nom de goniochromatisme). Cela est dû à l'aliasing dans le domaine spectral, car les moteurs de rendu en temps réel ne travaillent qu'avec trois composantes (RVB) pour l'ensemble de la gamme de la lumière visible. Dans ce travail, nous montrons comment antialiaser un modèle de couche mince, comment l'incorporer dans la théorie des microfacettes et comment l'intégrer dans un moteur de rendu en temps réel. Cela élargit la gamme d'apparences reproductibles avec les modèles à microfacettes.

Ombrage à lumière linéaire avec des cosinus transformés linéairement

Eric Heitz, Stephen Hill (Lucasfilm) - GPU Zen (livre)

Dans ce chapitre, nous étendons notre cadre d'éclairage de zone basé sur les cosinus transformés linéairement pour prendre en charge les éclairages linéaires (ou de ligne). Les lumières linéaires sont une bonne approximation des lumières cylindriques avec un rayon faible mais non nul. Nous décrivons comment approximer ces lumières avec des lumières linéaires qui ont une puissance et un ombrage similaires, et nous discutons de la validité de cette approximation.

Introduction pratique à l'analyse fréquentielle du transport de la lumière

Laurent Belcour - Cours ACM SIGGRAPH 2016

L'analyse fréquentielle du transport de la lumière exprime le rendu basé sur la physique (PBR) à l'aide d'outils de traitement du signal. Il est donc adapté pour prédire la fréquence d'échantillonnage, effectuer un débruitage, un anticrénelage, etc. De nombreuses méthodes ont été proposées pour traiter des cas spécifiques de transport de lumière (mouvement, lentilles, etc.). Ce cours vise à introduire des concepts et à présenter des scénarios d'application pratique de l'analyse fréquentielle du transport léger dans un contexte unifié. Pour faciliter la compréhension des éléments théoriques, l'analyse de fréquence sera introduite en même temps qu'une mise en œuvre.

2016

Ombrage polygonal en temps réel avec des cosinus transformés linéairement

Eric Heitz, Jonathan Dupuy, Stephen Hill (Ubisoft), David Neubelt (Ready at Dawn Studios) - ACM SIGGRAPH 2016

L'ombrage à l'aide d'éclairages de zone ajoute beaucoup de réalisme aux rendus d'images de synthèse. Cependant, elle nécessite la résolution d'équations sphériques, ce qui la rend difficile pour le rendu en temps réel. Dans ce projet, nous développons une nouvelle distribution sphérique qui nous permet d'ombrer des matériaux physiques avec des lumières polygonales en temps réel.