Voici un aperçu de nos principales mises à jour pour les différentes plateformes et de l'Éditeur. Pour en savoir plus, consultez les notes de version.

L'optimisation du Frame Pacing des images pour Android, développée en partenariat avec l’équipe de jeux et graphismes Android de Google, permet une meilleure fréquence d’image et une expérience plus fluide en répartissant les images plus uniformément.

En tant que développeur pour mobiles, vous pourrez aussi tirer parti de la prise en charge améliorée OpenGL. La prise en charge du multithreading OpenGL (iOS) améliore les performances sur des appareils iOS d'entrée de gamme non compatibles avec Metal (soit environ 25 % des appareils iOS exécutant des jeux Unity).

La prise en charge du batcher du pipeline de rendu programmable OpenGL (iOS et Android) améliore les performances du processeur dans les projets utilisant le pipeline de rendu léger.

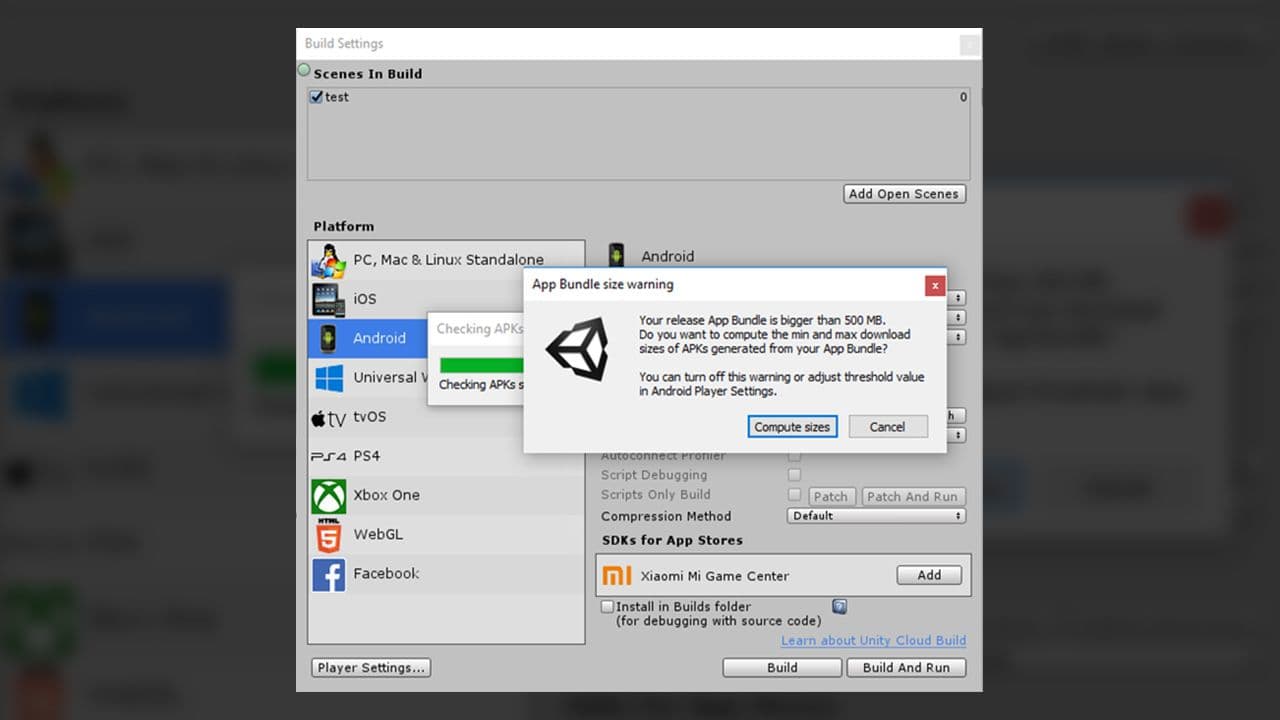

Grâce à cette nouvelle fonction, il est très facile de connaitre la taille finale des applications sur différentes cibles.

Ce système amélioré pour vos plateformes cibles vous aide à rationaliser le flux de développement. Seule la version d'aperçu est disponible. Nous cherchons des utilisateurs qui acceptent d'utiliser le nouveau flux de production et de nous donner leur avis.

Nous avons ajouté la prise en charge de la détection de visage, la détection d'images 2D, la détection d'objets 3D, les probes d'environnement et bien d'autres. Tous ces éléments sont disponibles en version aperçu.

Le HDRP inclut désormais la prise en charge des projets en RV (aperçu). Cette prise en charge est pour le moment limitée aux appareils sous Windows 10 et Direct3D11 et doit utiliser un rendu stéréo single-pass pour la RV avec le HDRP.

Accédez à toutes les fonctionnalités ci-dessus et bien plus dès aujourd'hui.